Meta千亿参数大模型OPT-IML「升级版」来了,完整模型和代码公布!

新智元报道

编辑:Joey 昕朋

【新智元导读】 继今年五月发布的首个千亿参数大模型OPT-175B后,Meta又重磅推出「升级版」OPT-IML,这次有何提升?

今年五月,MetaAI官宣发布了基于1750亿参数的超大模型OPT-175B,还对所有社区免费开放。

12月22日,该模型的更新版本OPT-IML(Open Pre-trained Transformer)正式上线,Meta称其「对2000个语言任务进行了微调,包含1750 亿个参数」,还将为非商业研究用途免费开放。

这次更新的OPT-IML的性能表现如何,先上两张图来看看。

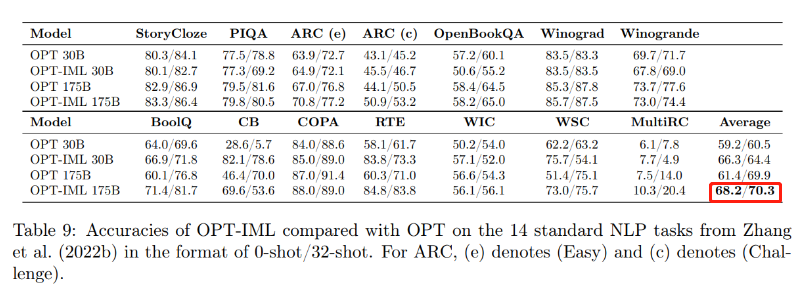

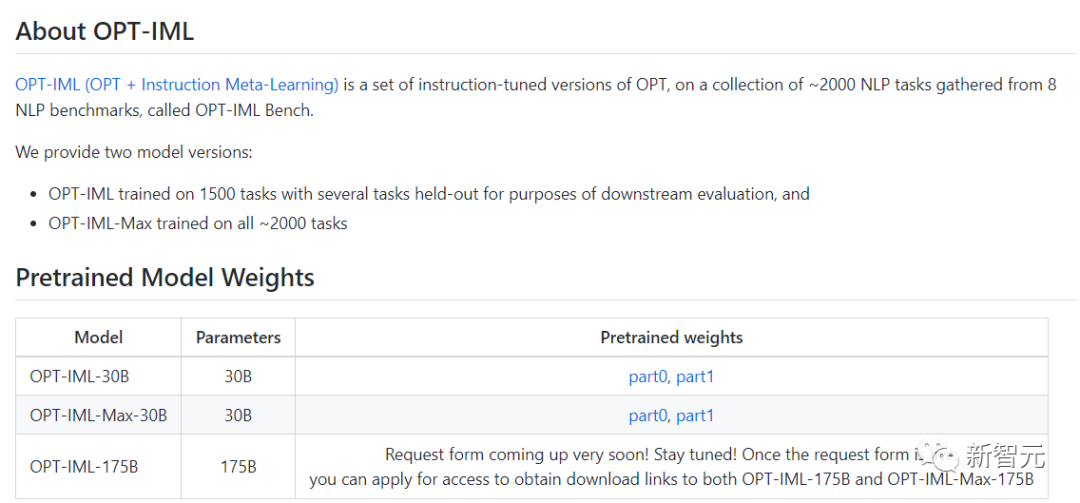

这次的OPT-IML创建了两种模型尺寸,分别是30B和175B。

与旧版OPT模型相比,OPT-IML在14个标准NLP评估任务中的平均表现均优于OPT。

在零次学习任务上两种模型大小分别好7%~ 和32-shot 任务分别好4%~ 和 0.4%~。

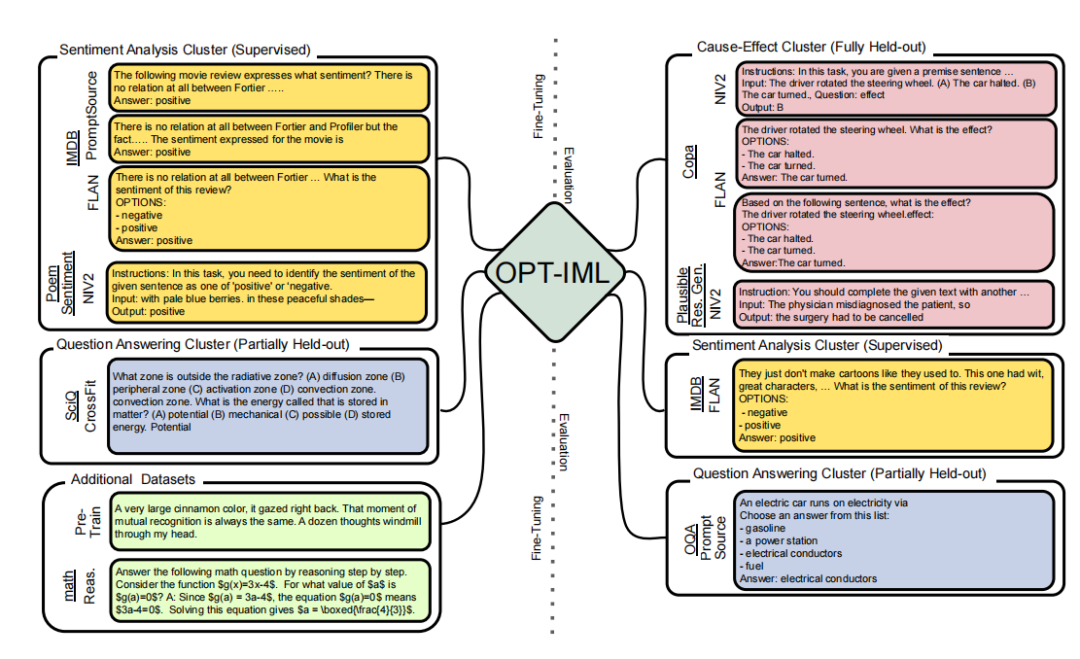

在这项研究中,研究人员描述了增加模型和基准大小如何影响指令调整决策对下游任务性能的影响。

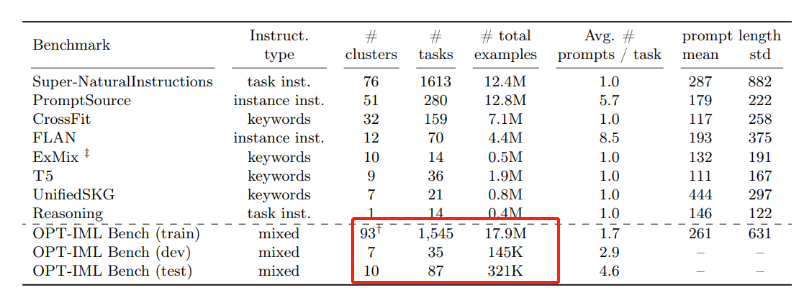

为此他们开发了 OPT-IML Bench,这是一个相当大的指令元学习 (IML) 基准,包含2000个NLP任务,这些任务根据现有的八个基准分为任务类别。

为训练OPT-IML 30B和175B,研究人员首先从该框架的角度对应用于 OPT-30B 的指令调优决策提出了见解。

在具有不同目标和输入格式的四个评估基准(PromptSource、FLAN、Super-NaturalInstructions 和 UnifiedSKG)上,OPT-IML 在两个尺度上展示了所有三种泛化技能。

它不仅在所有基准测试中显著优于OPT,而且以极具竞争力的方式优于针对该特定基准优化的现有模型。

此外OPT-IML已经开源,Github链接小编也放在下面啦~

Github链接:https://github.com/facebookresearch/metaseq/tree/main/projects/OPT-IML

接下来通过论文来一起了解一下OPT-IML。

论文链接:https://github.com/facebookresearch/metaseq/blob/main/projects/OPT-IML/optimal_paper_v1.pdf