检查下Label是不是从0开始的(贫僧没有遇到这个问题,具体看一看RuntimeError: cuda runtime error (59) : device-side assert triggered when running transfer_learning)。

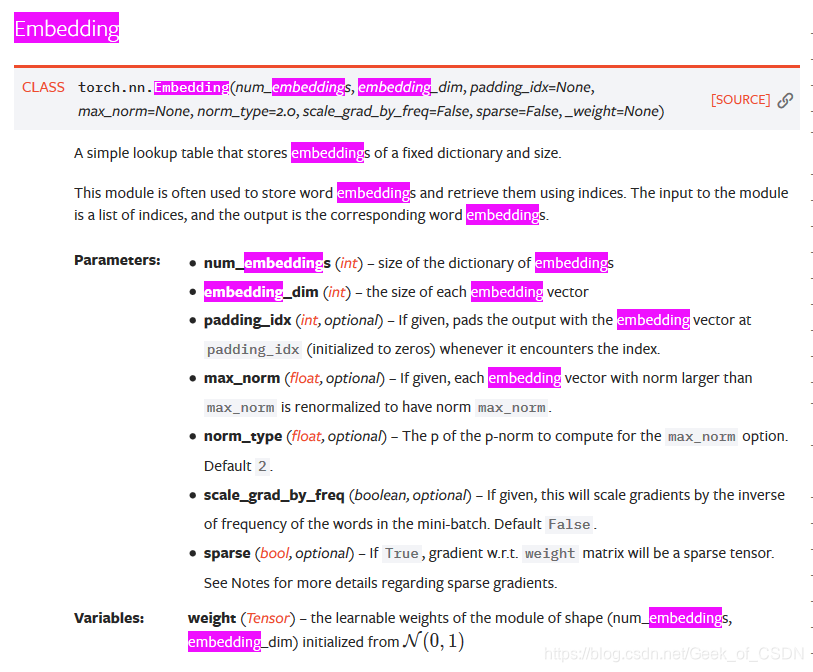

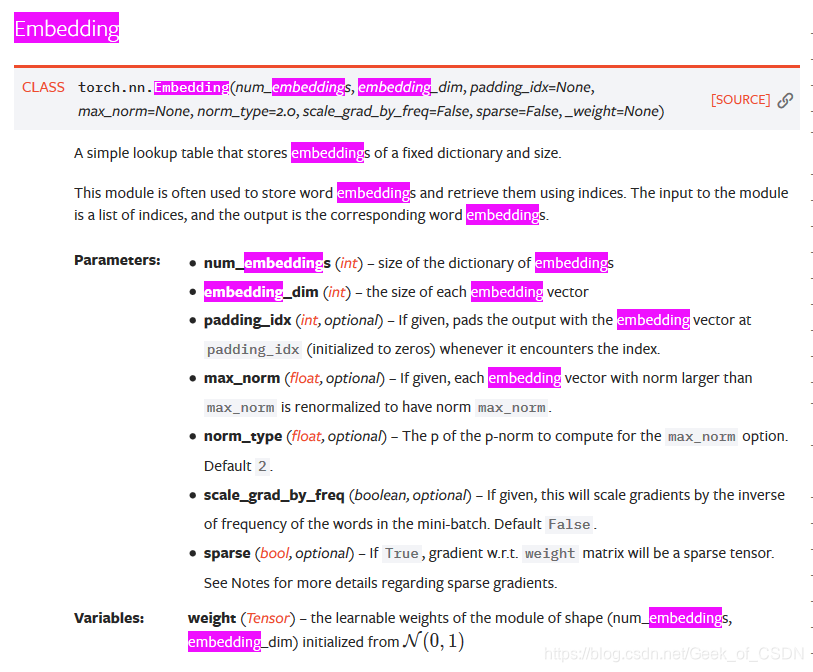

首先看下Embedding层的参数,看到那个num_embeddings了吗?要设置成你的字典的大小,但是要记住,一定是vocab_size + 1,而不是vocab_size,即要设置为字典大小+1。

嗯。。。基本上就是这样,其实还有别的经验,但是贫僧没有找到(其实您老根本就是懒得找吧),所以就这样吧。

近日,贫僧调试代码的时候不时遇到了“cuDNN error: CUDNN_STATUS_EXECUTION_FAILED”错误。这个错误其实挺奇怪的,有时最简单的处理方法就是重新运行代码,这个错误会自己消失。可能与jupyter的内存管理机制有关,具体原因未知。

RuntimeError: cuda runtime error (59) 官方PyTorch论坛上的问题,其实读者如果遇到问题的话也可以试试在上面提问(不要害羞,他们应该不会穿过网线来打你的,当然,在这方面贫僧可不敢做任何担保)

Debugging CUDA device-side assert in PyTorch这篇提到了Jupyter中怎么通过加入os.environ['CUDA_LAUNCH_BLOCKING'] = "1"来找哪里出了错

RuntimeError: cuda runtime error (59) : device-side assert triggered when running transfer_learning

pytorch runtime error(59):device-side assert triggered at XXX这篇则是关于词表(Embedding层)设置出错导致了这个bug

标题里的XXX是省略之后的文字的意思,不是真的“XXX”。某天贫僧在训♂练模型的时候遇到了这个错误提示。其实这个错误提示很模糊(非常模糊),基本上是没有办法定位到出错的地方的,在查找资料之后发现了一下解决方法(在这里总结下):1. 改为在CPU上运行这是因为当模型在GPU上运行的时候其实是没办法显示出真正导致错误的地方的(按照PyTorch Dev的说法:“Because of the as...

三重态SemiHardLoss

PyTorch半硬。基于可在找到的tensorflow插件版本。无需使用此实现来创建暹罗体系结构,就像创建main_train_triplet.py cnn创建过程一样简单!

对于具有N_CLASSES >> N_SAMPLES_PER_CLASS的分类问题,三元组损失是一个不错的选择。例如,人脸识别问题。

在分类层之前,我们需要切断具有三重态损失的CNN架构。另外,必须添加L2归一化层。

MNIST上的结果

我在MNIST数据集上测试了三重态损失。我们无法直接与TF插件进行比较,因为我没有进行实验,但是从性能的角度来看这可能很有趣。如果您想比较结果,这是训练日志。准确性无关紧要,因为我们不训练分类模型,所以准确性不应该存在。

首先,我们训练最后一层和批次归一化层,使验证损失接近0.079。

最后,解冻所有层,经过足够的训练和超参数调整

跑模型时出现RuntimeError: CUDA out of memory.错误 查阅了许多相关内容,原因是:GPU显存内存不够

简单总结一下解决方法:

将batch_size改小。

取torch变量标量值时使用item()属性。

可以在测试阶段添加如下代码:

with torch.no_grad(): # 停止自动反向计算梯度

https://wisdomai.xyz/tool/pytorch/archives/2301

https://ptorch.com/news/160.html

作者:菜叶儿掉啦

1.使用您的数据集训练模型并在supervisely.ly上使用unet_train.py保存模型权重(.pt文件)

2.使用pytorch_to_onnx.py将模型权重转换为ONNX格式

3.使用crack_det_new.py获取实时推理

裂纹分割模型文件可点击此下载

1 CUDA kernel errors might be asynchronously reported at some other API call,so the stacktrace below might be incorrect.For debugging consider passing CUDA_LAUNCH_BLOCKING=1.

在代码中加入

os.environ['CUDA_LAUNCH_BLOCKING'] = '1'

可以将错误的具体位置显示出来。

以上的问题大多是网络中的labe

RuntimeError: CUDA error: invalid device ordinal

CUDA kernel errors might be asynchronously reported at some other API call,so the stacktrace below might be incorrect.

For debugging consider passing CUDA_LAUNCH_BLOCKING=1.

LSTM-Shuttle是“” 和在自然语言处理的经验方法会议( EMNLP )2018中(长期)

LSTM-Shuttle不仅向前读取穿梭内容,而且向后走。 向前穿梭可提高效率,向后穿梭可使模型有机会恢复丢失的信息,从而确保更好的预测。 它首先顺序读取固定数量的单词,然后输出隐藏状态。 然后,基于隐藏状态,LSTM-Shuttle计算前进或后退步幅上的Shuttle softmax分布。

该代码在Python3和下实现。 还需要以下库:

> = 0.4

我们将用作预训练的词嵌入。

LSTM-香草

model_lstm-vanilla.ipynb

LSTM跳跃

model_lstm-jump.ipynb

LSTM穿梭机

model_lstm-shu

PyTorch-Spiking-YOLOv3

基于YOLOv3的PyTorch实现( )的Spiking-YOLOv3的PyTorch实现,目前支持Spiking-YOLOv3-Tiny。 整个Spiking-YOLOv3即将得到支持。

为了实现尖峰效果,YOLOv3-Tiny中的某些运算符已进行等效转换。 有关详细信息,请参阅/ cfg中的yolov3-tiny-ours(*)。cfg。

某些运营商的转换

'maxpool(stride = 2)'->'convolutional(stride = 2)'

'maxpool(stride = 1)'->'none'

'upsample'->'transposed_convolutional'

'leaky_relu'->'relu'

'批处理标准化'->'fuse_conv_and_bn'

有关培训,评估和推断的基

import torch_optimizer as optim

# model = ...

optimizer = optim . DiffGrad ( model . parameters (), lr = 0.001 )

optimizer . step ()

安装过程很简单,只需:

$ pip install torch_optimizer

https://pytorch-optimizer.rtfd.io

支持的优化器

A2GradExp

https://arxiv.org/abs/1810.00553

A2GradInc

https://arxiv.org/abs/1810.00553

A2GradUni

https://arxiv.org/abs/1810.00

这个错误出现在使用CUDA时,通常是因为指定的设备编号不正确或设备不存在。例如,代码可能会尝试在一个只有一个GPU的机器上使用第二个GPU。或者,如果在运行之前添加了或移除了GPU,也可能会出现此错误。

为了解决这个问题,你需要首先检查你的代码中是否存在指定设备编号的代码行,并确保正确地指定了设备编号。如果检查后仍然有问题,可以尝试在代码中添加错误处理代码,以便在运行时捕获错误并提示用户,或者使用第三方库来管理CUDA设备,以确保正确使用它们。

此外,如果你正在使用TensorFlow或PyTorch等深度学习库,可能还需要更新这些库的版本或驱动程序版本,以确保它们与使用的CUDA版本兼容。