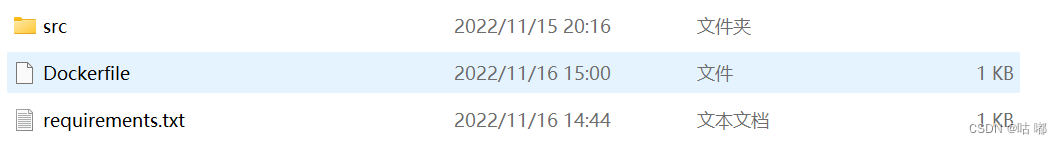

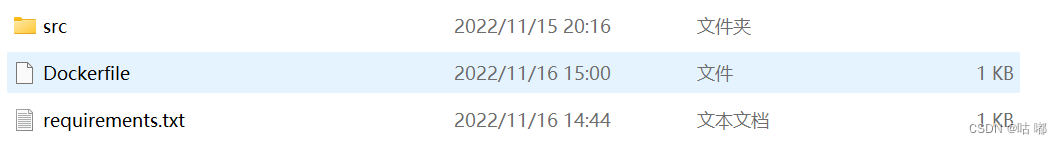

1、新建一个文件夹

里面包含三个文件,分别是Python项目文件、requirements.txt、Dockerfile

2、编写Dockerfile

这个按照自己的环境以及需求进行修改

#基于的基础镜像

FROM python:3.6.8

#代码添加到code文件夹

ADD . /code

# 设置code文件夹是工作目录

WORKDIR /code

# 安装支持

RUN pip install -r requirements.txt

CMD ["python", "/code/src/main.py"]

3、生成项目依赖requirements.txt

这里有很多种方式可以生成,本文使用的是popreqs这个工具,这个工具能够只将当前项目所需要的库导出。

pipreqs ./ --encoding='utf-8' --force

前往项目路径运行上述命令

4、生成Docker镜像

docker build -t [image_name] .

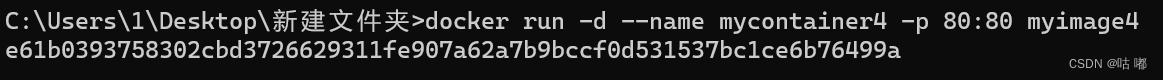

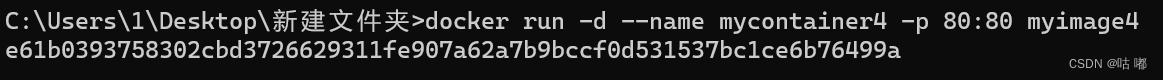

5、将生成的镜像运行到容器当中

docker run -d --name [container_name] -p 80:80 [image_name]

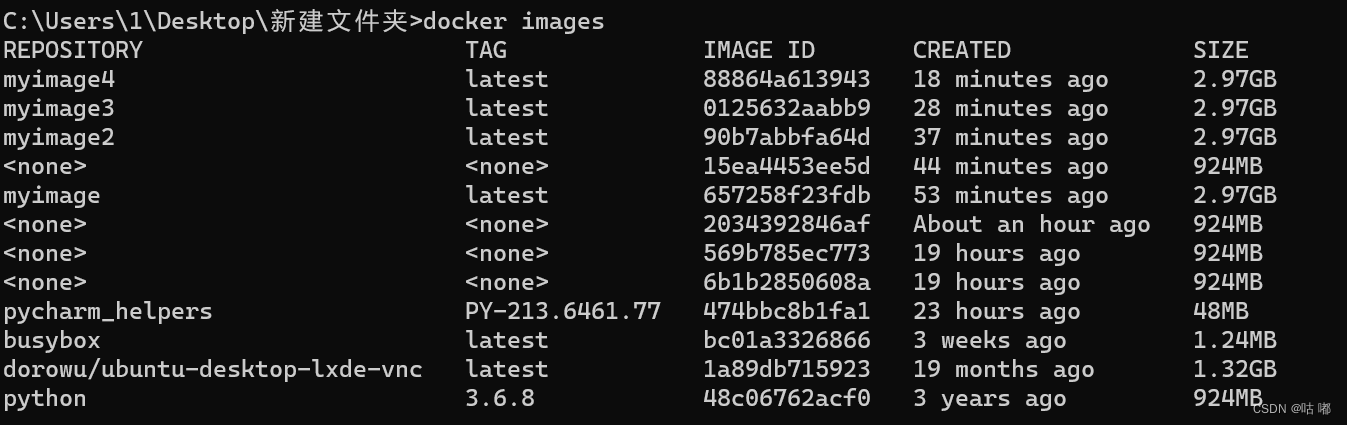

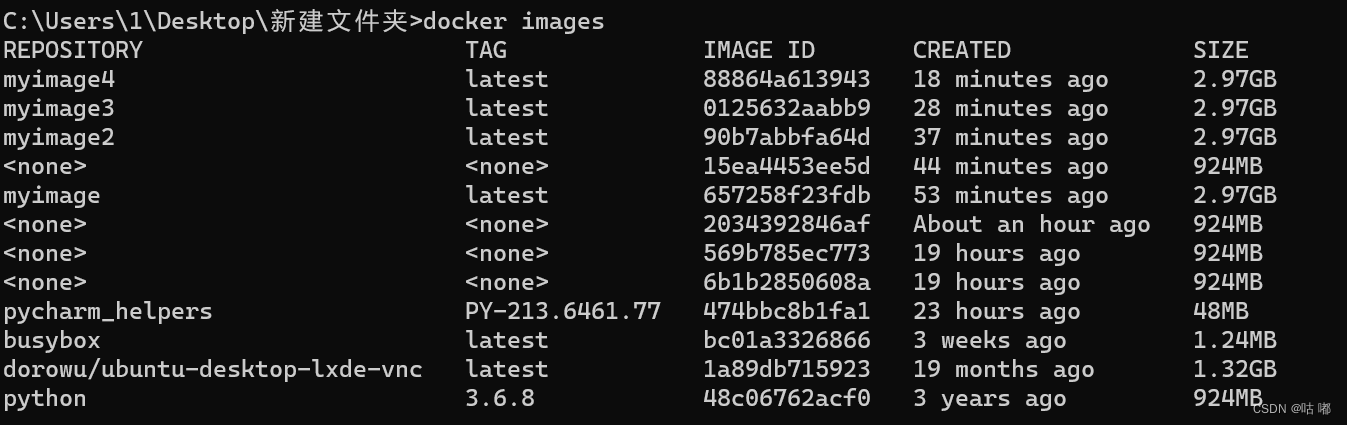

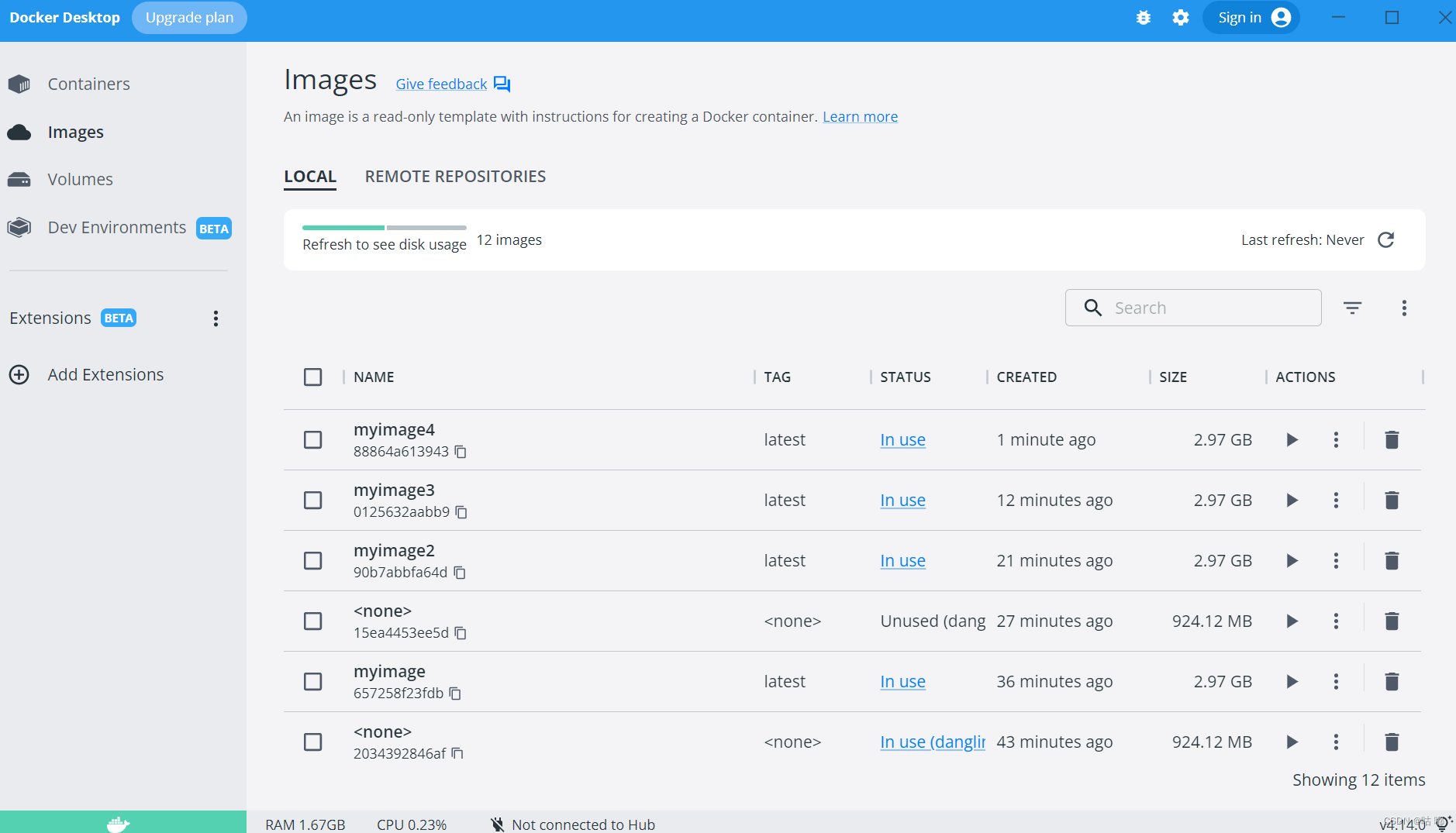

6、查看镜像

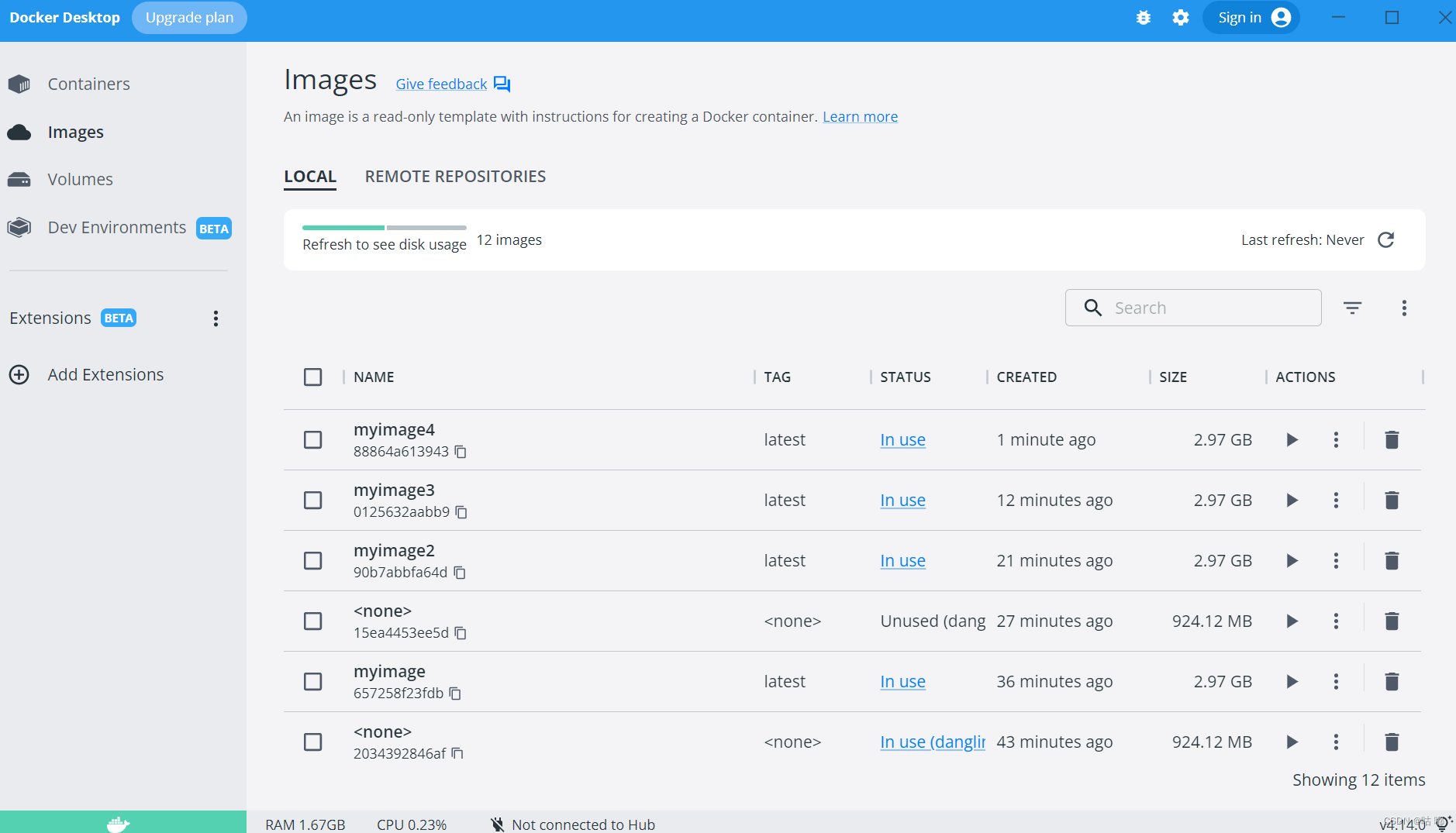

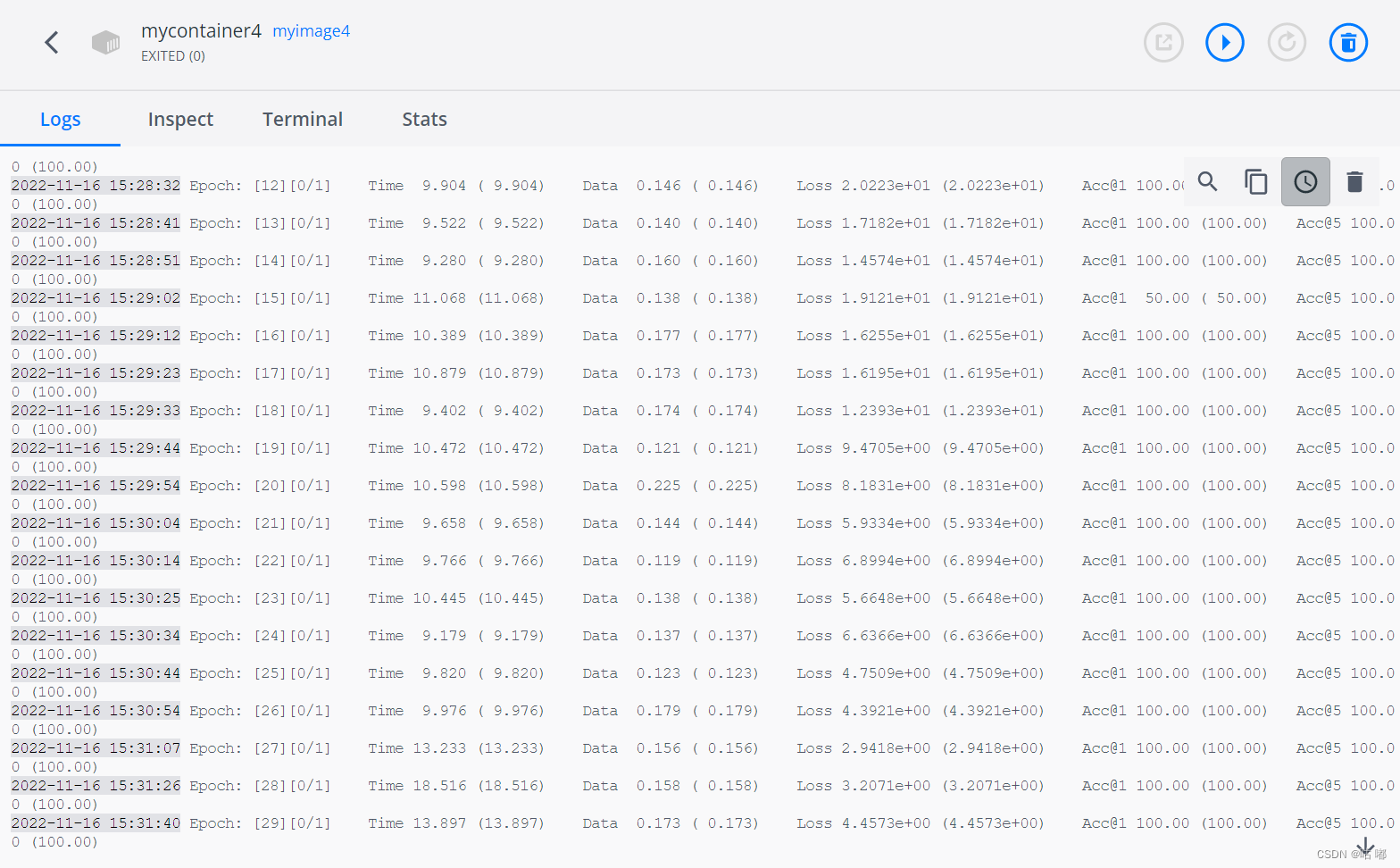

7、运行镜像

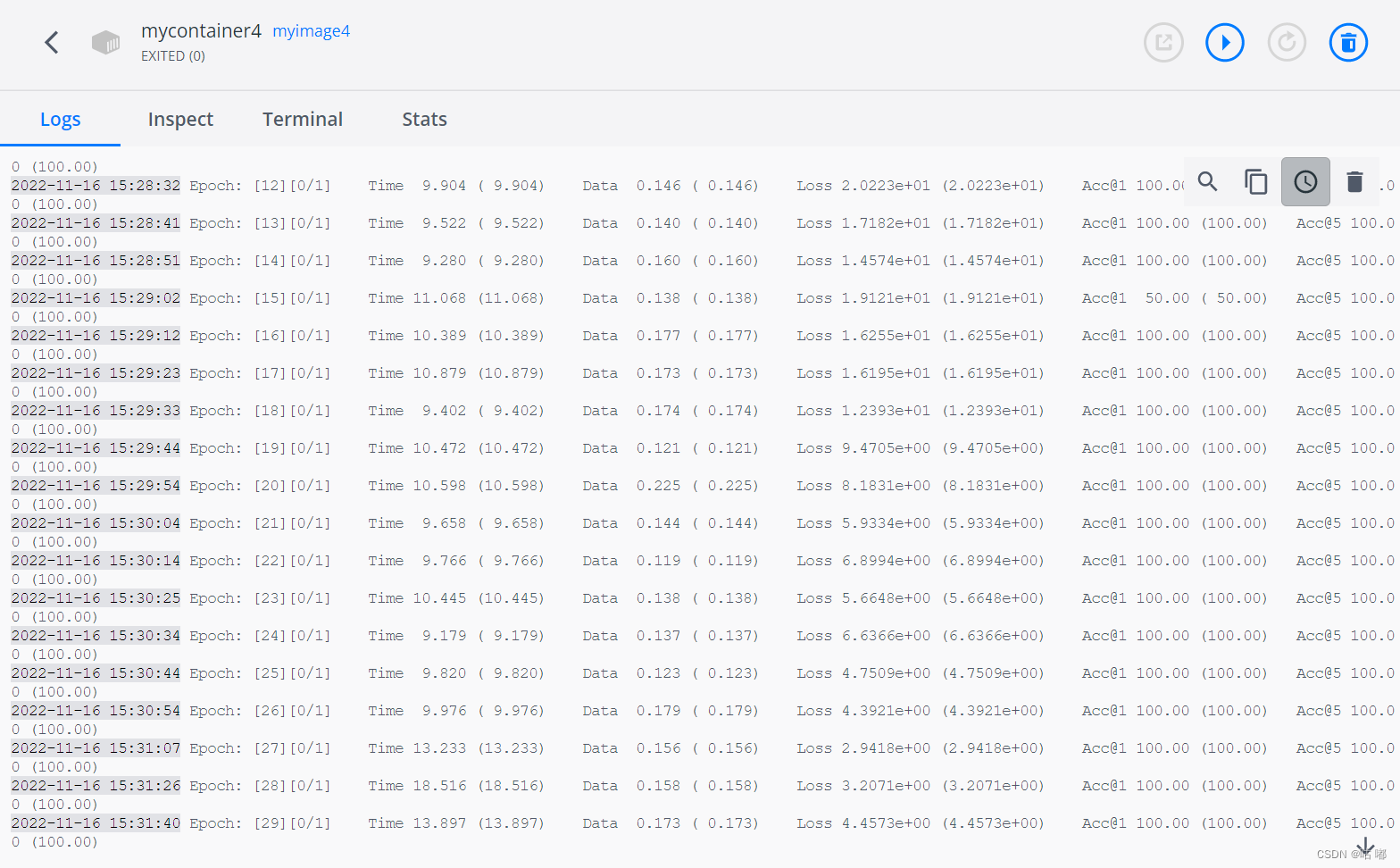

8、查看运行日志

pycocotools即python api tools of COCO。COCO是一个大型的图像数据集,用于目标检测、分割、人的关键点检测、素材分割和标题生成

今天自动驾驶之心很荣幸邀请到逻辑牛分享深度学习部署的入门介绍,带大家盘一盘ONNX、NCNN、OpenVINO等框架的使用场景、框架特点及代码示例。

今天自动驾驶之心很荣幸邀请到逻辑牛分享深度学习部署的入门介绍,带大家盘一盘ONNX、NCNN、OpenVINO等框架的使用场景、框架特点及代码示例。

本文将详细介绍如何开发和部署 Serverless 应用,并通过阿里云函数计算控制台与开发者工具 Serverless Devs 进行应用的初始化、部署;最后分享应用的调试,通过科学发布、可观测性等介绍应用的部署和运维总结,进而实现从应用初始化到调试、发布、运维基础流程、核心步骤的探索。

1. ONNX的简介

Open Neural Network Exchange(ONNX,开放神经网络交换)格式,是一个用于表示深度学习模型的标准,可使模型在不同框架之间进行转移(一般用于中间部署阶段)。

本文介绍AI模型适用于小型本地设备上的方法技术:压缩模型参数量,设计更小的模型结构,知识蒸馏,调整数据格式,数据复用等,并介绍移动小处理设备的类型、适用移动设备的模型框架等。

本课程设计是开发一款具备AI能力的微信小程序,为了能让真机测试通过并成功上线,需要把flask+Pytorch深度学习模型部署到阿里云服务器,实现前后端的交互。对于服务器部署我们使用nginx进行ssl证书部署,修改nginx.conf文件,安装gunicorn库通过命令gunicorn -w 2 -b 127.0.0.1:5000 -demo:app命令来运行项目,使前后端能够交互,实现小程序的核心功能。