"name":"debezium-test-5017",

"config":{

"connector.class":"io.debezium.connector.mysql.MySqlConnector",

"database.hostname":"4.4.4.4",

"database.port":"5017",

"database.user":"test",

"database.password":"123",

"database.server.id":"316545017",

"database.server.name":"debezium",

"database.history.kafka.bootstrap.servers":"1.1.1.1:7091,2.2.2.2:7091,3.3.3.3:7091",

"database.history.kafka.topic":"debezium_test"

-- 其余常用配置

"database.include.list": "zztest"

"database.exclude.list": "zztest"

"table.include.list": "t1"

"table.exclude.list": "t1"

"column.include.list": "col1"

"column.exclude.list": "col1"

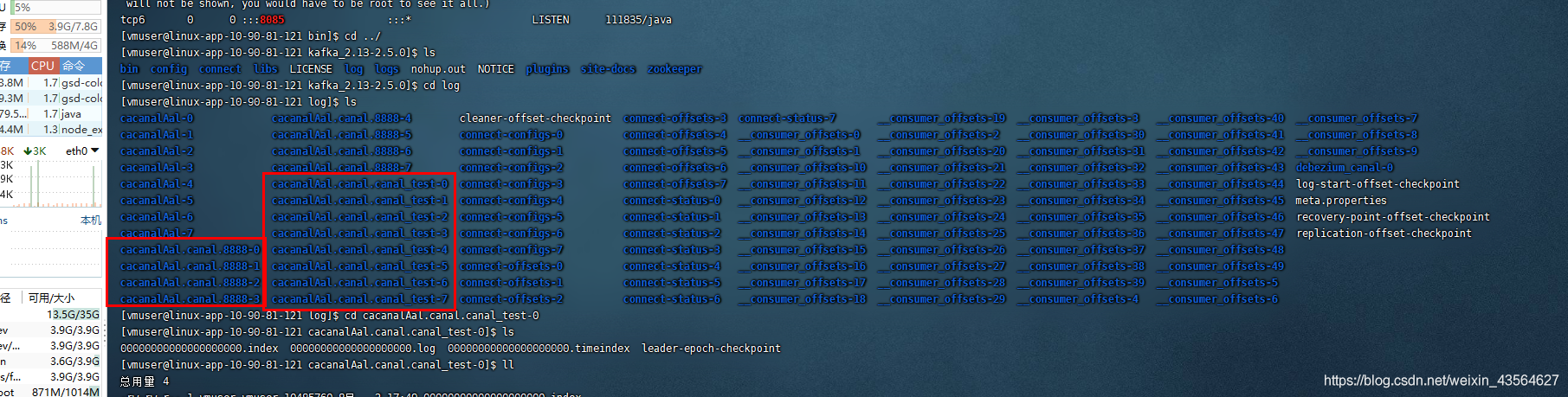

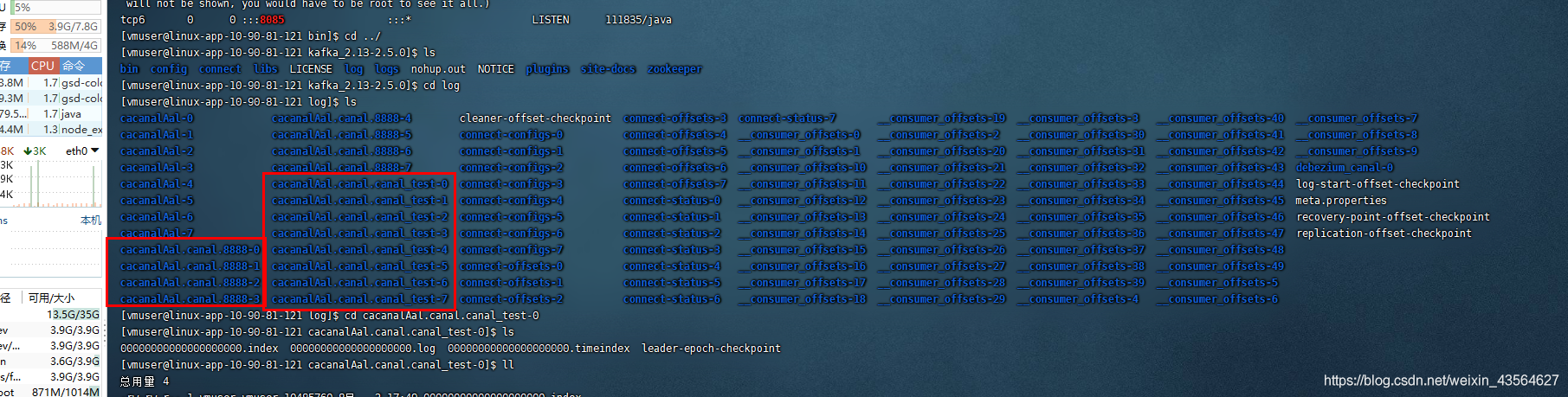

如果投递成功 我这里 应该 会生成两个 topic

其中 表 topic_test和 表 topic_test1 和 表 topic_test2 对应一个 topic cacanalAal.canal.canal_test

表 8888 对应 topic cacanalAal.canal.888

在这几张表中 分别插入一些数据

然后去查询 topic 的log

cd /service/software/debezium/kafka_2.13-2.5.0/log

执行 ls 如下

验证 数据是否进入 对应的 topic

grep -rn ‘topic_test’ cacanalAal.canal-/.log

grep -rn ‘topic_test1’ cacanalAal.canal-/.log

grep -rn ‘topic_test2’ cacanalAal.canal-/.log

grep -rn ‘8888’ cacanalAal.cana*/*.log

结果如下

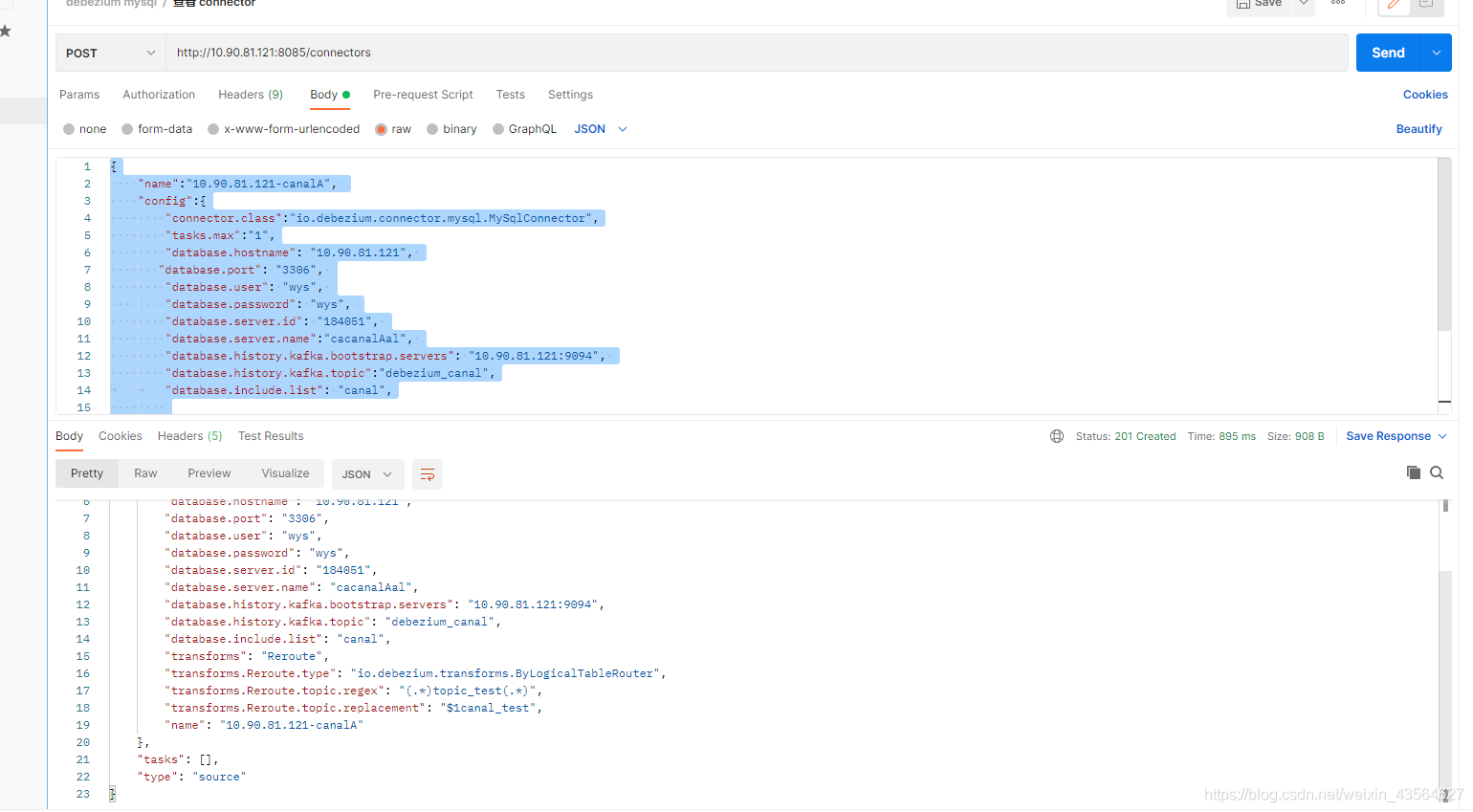

Debezium同步多个表投递到一个TopicDebezium 是否支持同步 多个表投递到一张topic?答 : 支持验证如下:官方说明: https://debezium.io/documentation/reference/1.5/configuration/topic-routing.html数据库db如下配置如下{ "name":"10.90.81.121-canalA", "config":{ "connector.class":"io.deb

Debezium系列之:记录一次生产环境debezium版本升级步骤一、保存Debezium所有connector的配置二、保存debezium connector binlog文件的消费位置

一、保存Debezium所有connector的配置

使用代码一次性保存所有运行的debezium connector的配置,主要用来防止debezium升级过程中出现意外,当出现意外的情况下,可以使用代码一次性快速提交所有的connector,快速恢复debezium connector

部分核心代码如下所示:

数仓实时数据同步 debezium背景debezium 简介架构基本概念例子目前遇到的问题

数据湖将源库的数据同步到hive数仓ods层,或直接在kafka中用于后面计算。源库包括mysql、postgresql、sqlserver、oracle,大部分是mysql数据库。当前采用的sqoop T+1全量或增量抽取的方式,时效性低,delete的数据可能无法被正确处理。

选择debezium的原因:数据源支持众多,使用的组件仅仅是kafka,需要进行的开发少;debezium使用kafka-conne

Debezium系列之:把

多个数据库中多张

表的数据发送到

一个Kafka topic中一、

Debezium专栏博客每周更新计划二、需求描述三、参数设置四、提交

debezium connector参数示例

一、

Debezium专栏博客每周更新计划

后续每周在日常更新

Debezium技术文章的同时,会以一定频率

同步更新

Debezium源码阅读系列文章,欢迎与博主交流

Debezium相关技术,一起加油。

二、需求描述

需要把

一个数据库中的多张

表的数据,全部导入

同一个kafka topic中

GreatSQL社区原创内容未经授权不得随意使用,转载请联系小编并注明来源。

GreatSQL是MySQL的国产分支版本,使用上与MySQL一致。 一、Debezium介绍

摘自官网:

Debezium is a set of distributed services to capture changes in your databases so that your applications can see those changes and respond to them. Debezium recor

近期公司在响应国家软件规范要求,重点项目的数据库采用开源版postgresql(下文简称pg),业务端依然使用oracle。因此为了保证pg到oracle的数据

同步问题,经过调研采用

Debezium开源项目,实现 pg ->

kafka-> oracle 的数据实时

同步。

开始介绍重点…

Debuzium简介

Debezium是Apache

Kafka Connect的一组源连接器(source端),通过款实现剖析数据库中binlog日志,捕获数据,拷贝到

kafka中,实现数据的实时抽取。

1. 确定需求和功能:确定需要哪些功能,比如发布招聘信息、搜索职位、注册登录、个人信息管理等。

2. 数据库设计:设计数据库表结构,包括用户表、职位表、招聘公司表等。

3. 搭建Spring Boot项目:使用Spring Initializr创建一个基本的Spring Boot项目。

4. 配置数据库连接:在项目中添加数据库的配置信息,并连接数据库。

5. 实现用户模块:包括用户注册、登录、个人信息管理等功能。

6. 实现职位模块:包括发布职位、搜索职位等功能。

7. 实现招聘公司模块:包括招聘公司信息管理、发布招聘信息等功能。

8. 实现简历模块:包括简历的上传、编辑、投递等功能。

9. 实现站内信模块:包括发送和接收站内信等功能。

10. 实现权限管理:使用Spring Security实现用户权限管理。

11. 测试和部署:完成代码编写后进行测试,最后将项目部署到服务器上。

以上只是一个简单的流程,具体实现还需要根据需求进行调整和完善。

额外参数说明

额外参数说明