以往有篇文章介绍

EFK(Kibana + ElasticSearch + Filebeat)

的插件日志收集。Filebeat 插件用于转发和集中日志数据,并将它们转发到 Elasticsearch 或 Logstash 以进行索引,但 Filebeat 作为 Elastic 的一员,只能在 Elastic 整个体系中使用。

Fluentd

Fluentd是一个开源的,分布式日志采集系统,可以从不同的服务,数据源采集日志,对日志进行过滤加工,分发给多种存储和处理系统。支持各种插件,数据缓存机制,且本身所需的资源很少,内置可靠性,结合其他服务,可以形成高效直观的日志收集平台。

本文介绍在 Rainbond 中使用 Fluentd 插件,收集业务日志,输出到多个不同的服务。

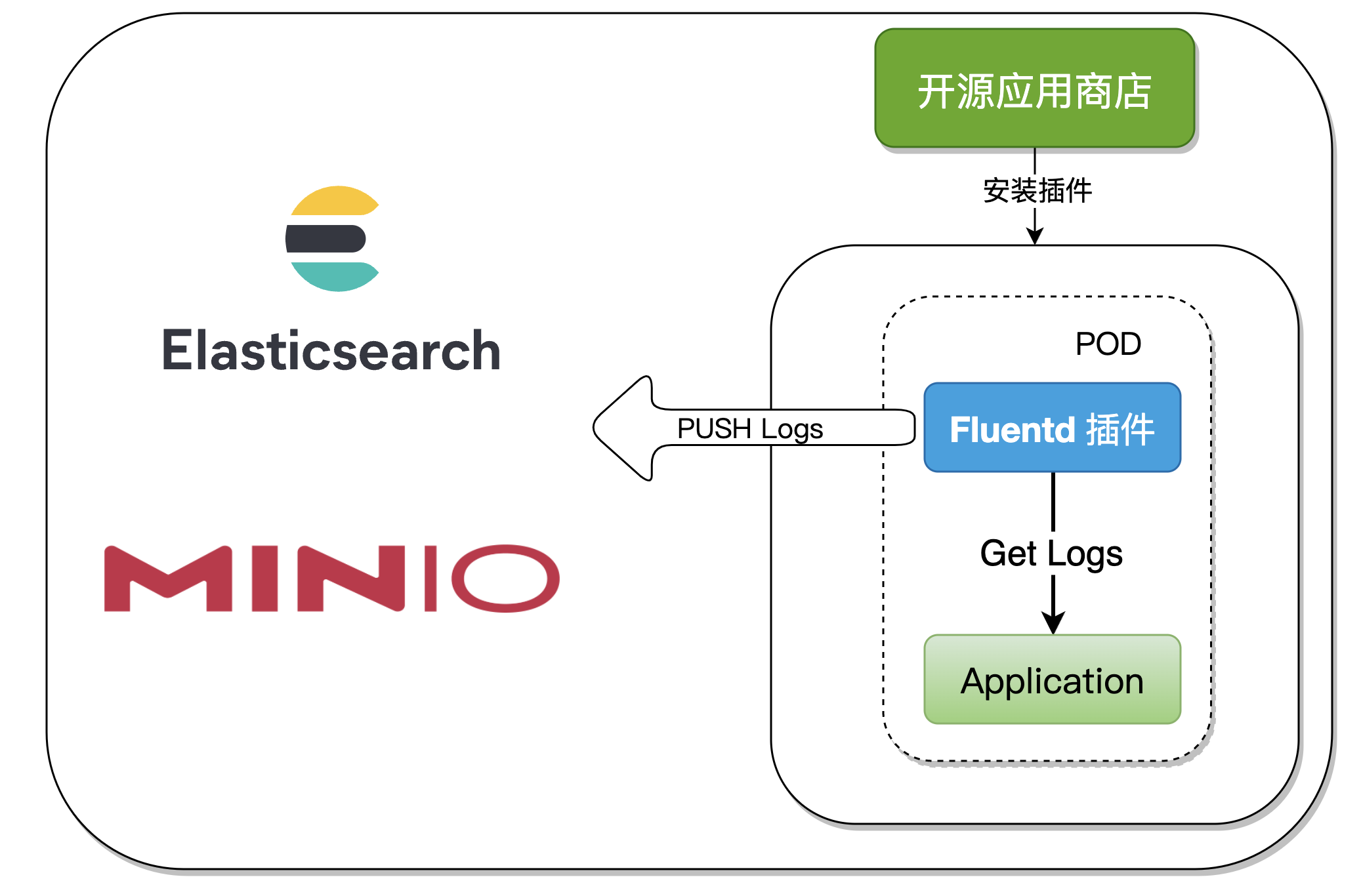

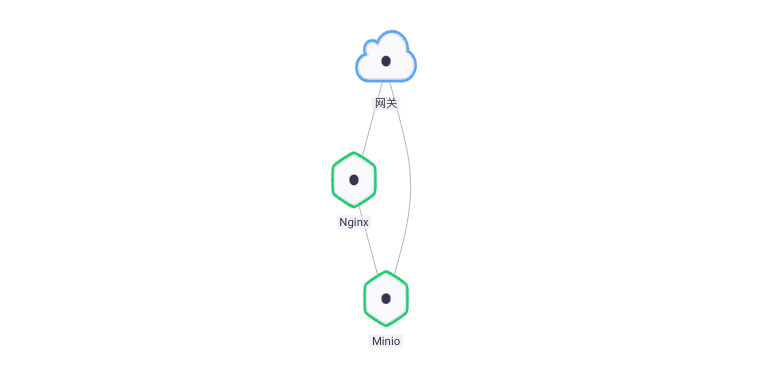

一、整合架构

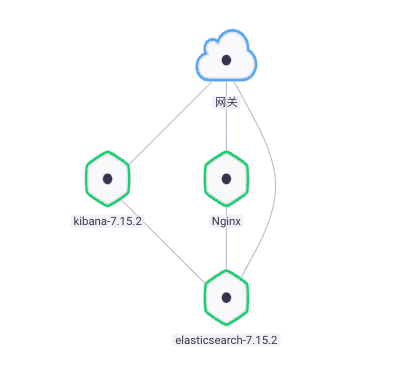

在收集组件日志时,只需在组件中开通 Fluentd 插件,本文将演示以下两种方式:

-

Kibana + ElasticSearch + Fluentd

-

Minio + Fluentd

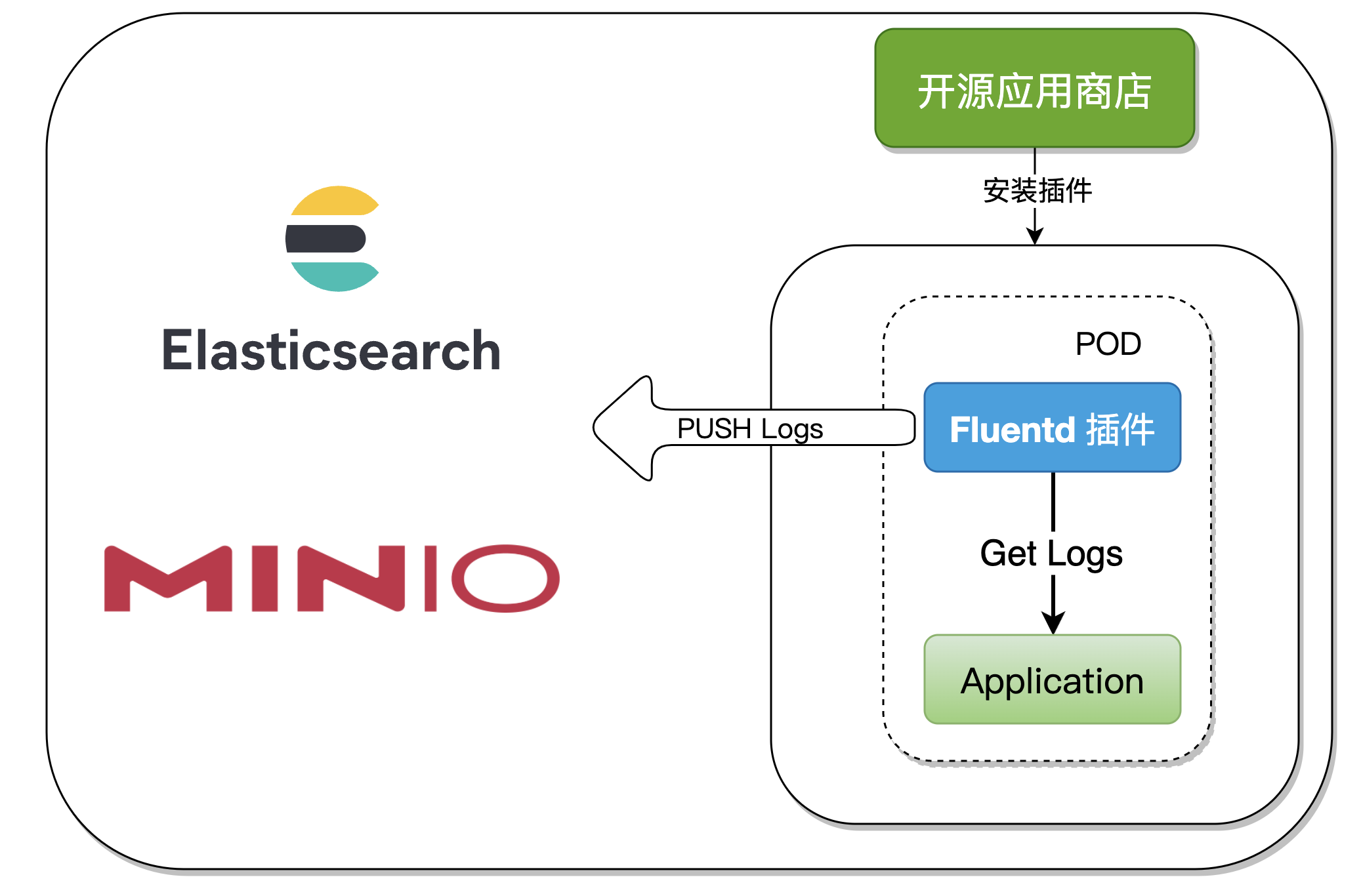

我们将 Fluentd 制作成 Rainbond 的

一般类型插件

,在应用启动之后,插件也随之启动并自动收集日志输出到多个服务源,整个过程对应用容器无侵入,且拓展性强。

二、插件原理分析

Rainbond V5.7.0 版本中新增了:

「

从开源应用商店安装插件

」

,本文中的插件已发布到开源应用商店,当我们使用时一键安装即可,根据需求修改配置文件。

Rainbond 插件体系是相对于 Rainbond 应用模型的一部分,插件主要用来实现应用容器扩展运维能力。由于运维工具的实现有较大的共性,因此插件本身可以被复用。插件必须绑定到应用容器时才具有运行时状态,用以实现一种运维能力,比如性能分析插件、网络治理插件、初始化类型插件。

在制作 Fluentd 插件的过程中,使用到了

「

一般类型插件

」

,可以理解为一个POD启动两个 Container,Kubernetes原生支持一个POD中启动多个 Container,但配置起来相对复杂,在 Rainbond 中通过插件实现使用户操作更加简单。

三、EFK 日志收集实践

Fluentd-ElasticSearch7 输出插件将日志记录写入 Elasticsearch。默认情况下,它使用批量 API创建记录,该 API 在单个 API 调用中执行多个索引操作。这减少了开销并可以大大提高索引速度。

3.1 操作步骤

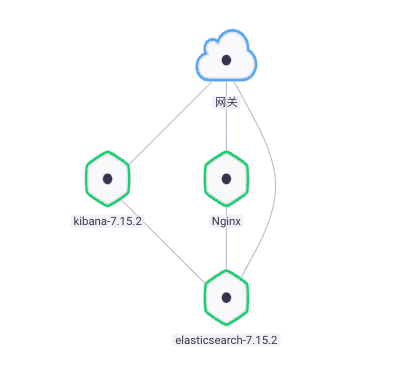

应用 (Kibana + ElasticSearch)和插件(Fluentd)都可以通过开源应用商店一键部署。

-

对接开源应用商店

-

在应用商店中搜索

elasticsearch

并安装

7.15.2

版本。

-

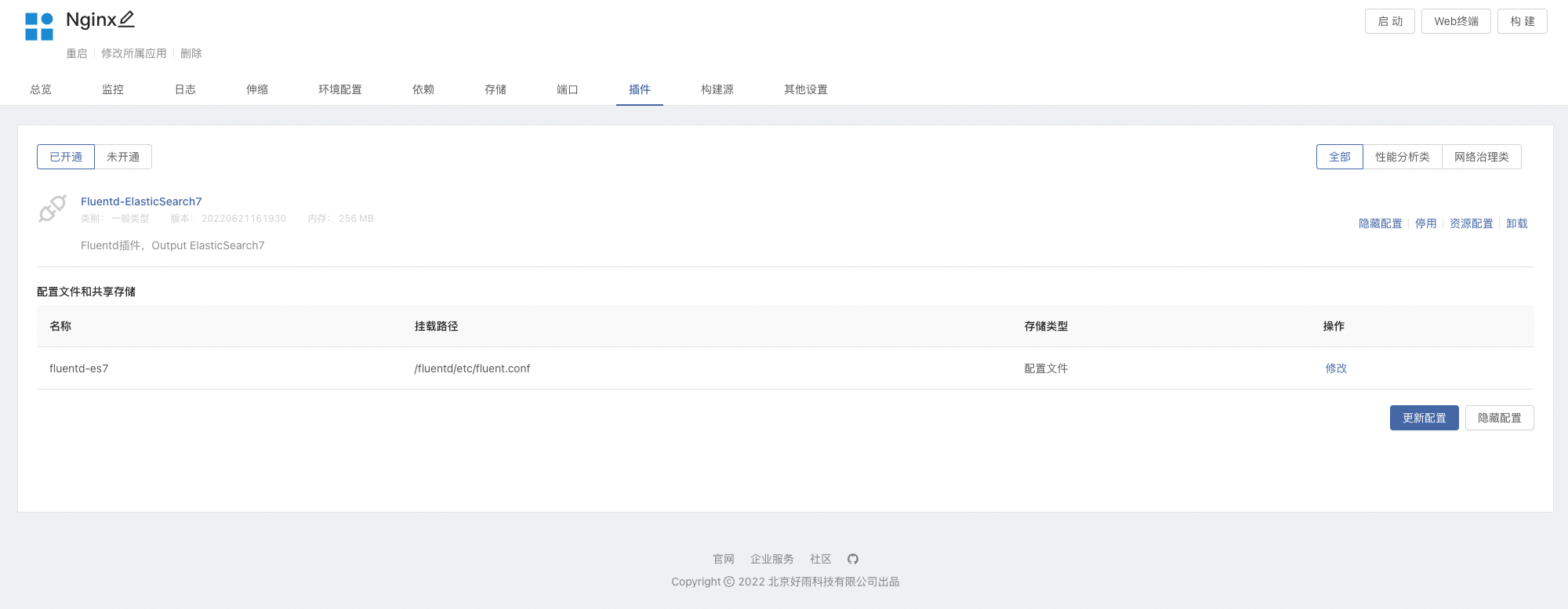

团队视图 -> 插件 -> 从应用商店安装

Fluentd-ElasticSearch7

插件

-

基于镜像创建组件,镜像使用

nginx:latest

,并且挂载存储

var/log/nginx

。这里使用

Nginx:latest

作为演示

-

在组件内挂载存储后,插件也会自定挂载该存储,并可访问 Nginx 产生的日志文件。

-

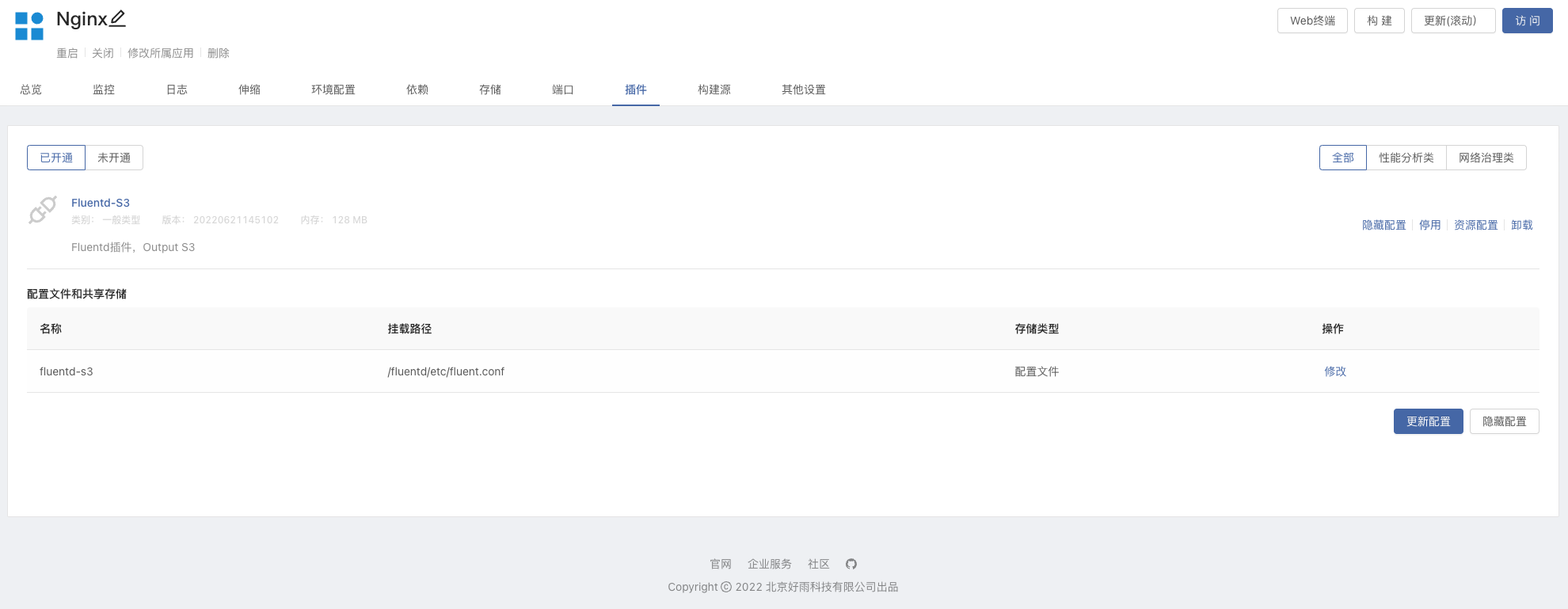

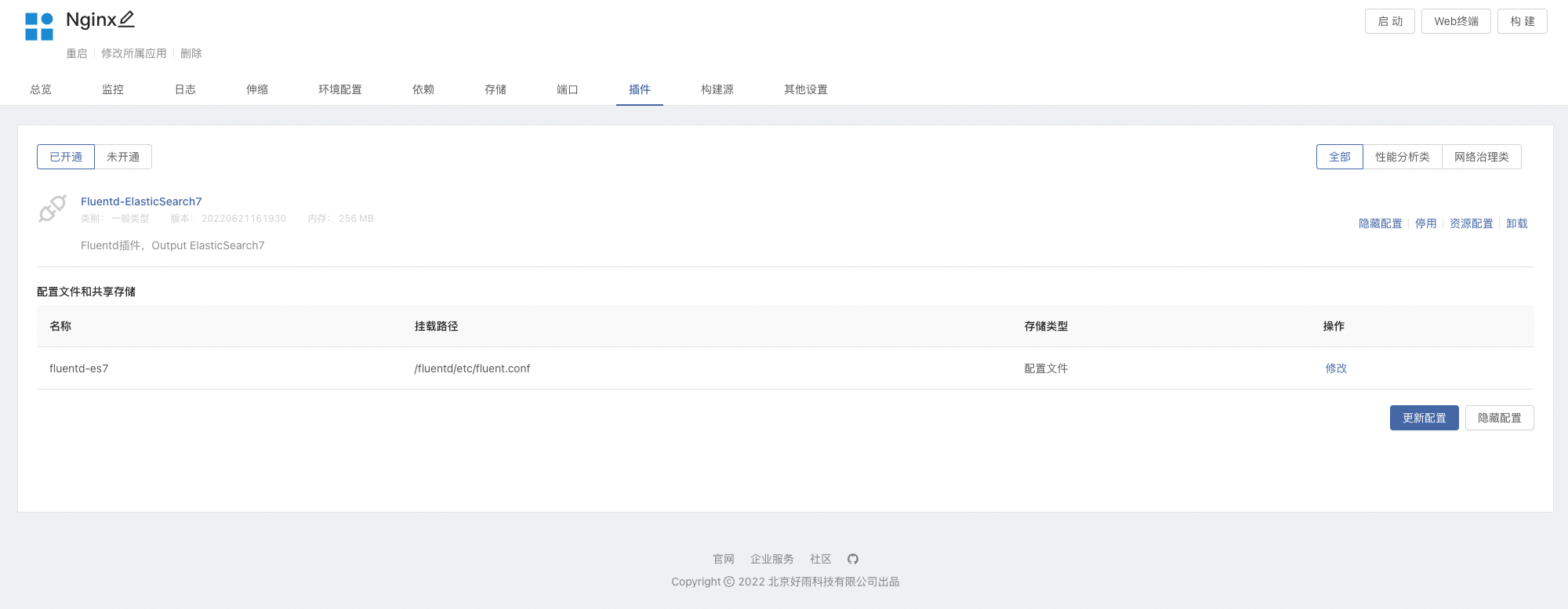

在 Nginx 组件内开通插件,可以根据所需进行修改

Fluentd

配置文件,可参考下方配置文件简介部分。

-

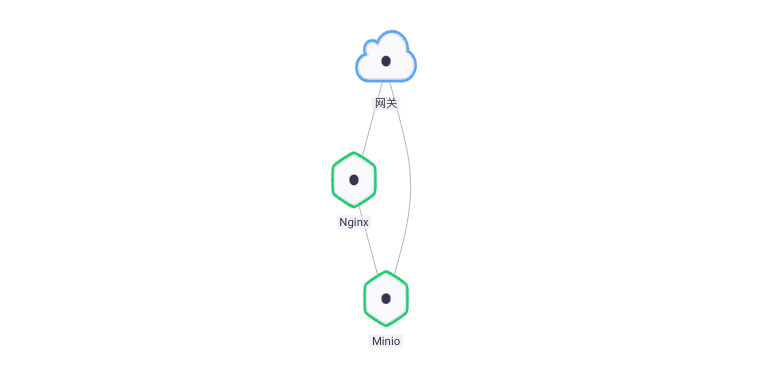

添加 ElasticSearch 依赖,将 Nginx 连接到 ElasticSearch,如下图:

-

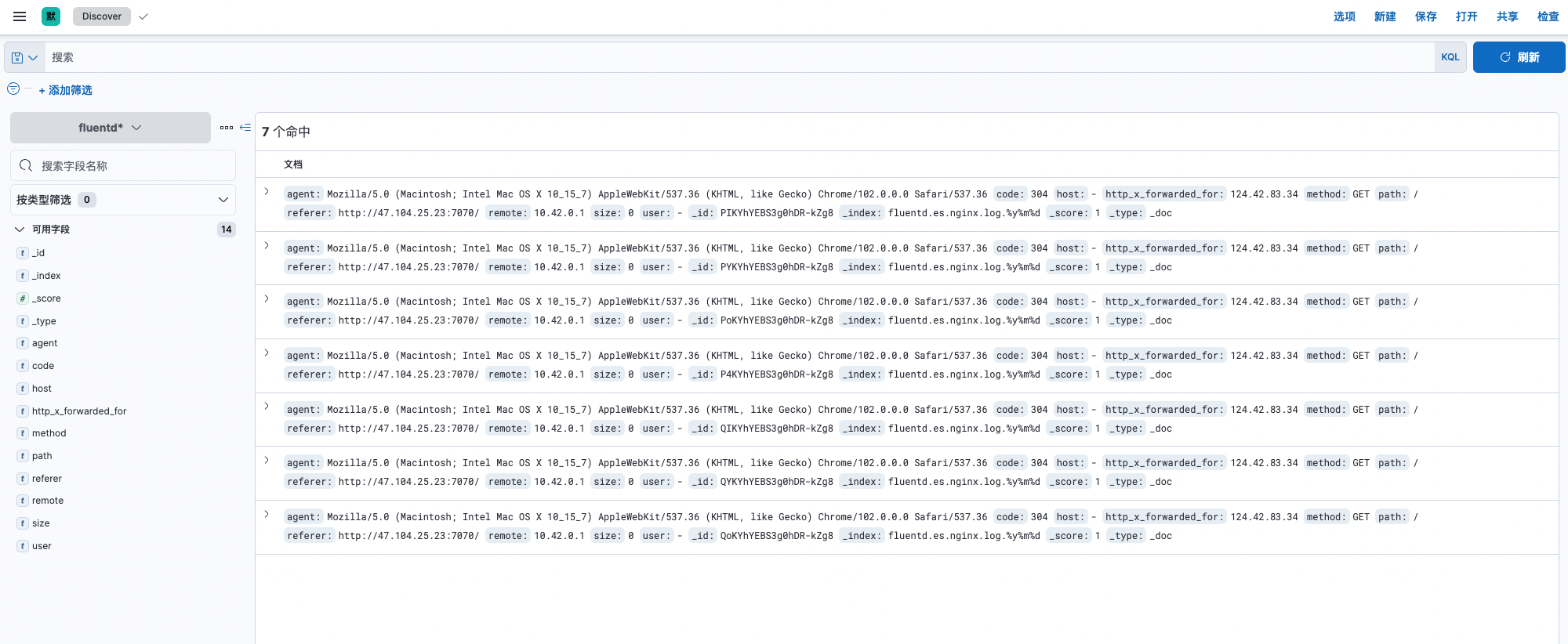

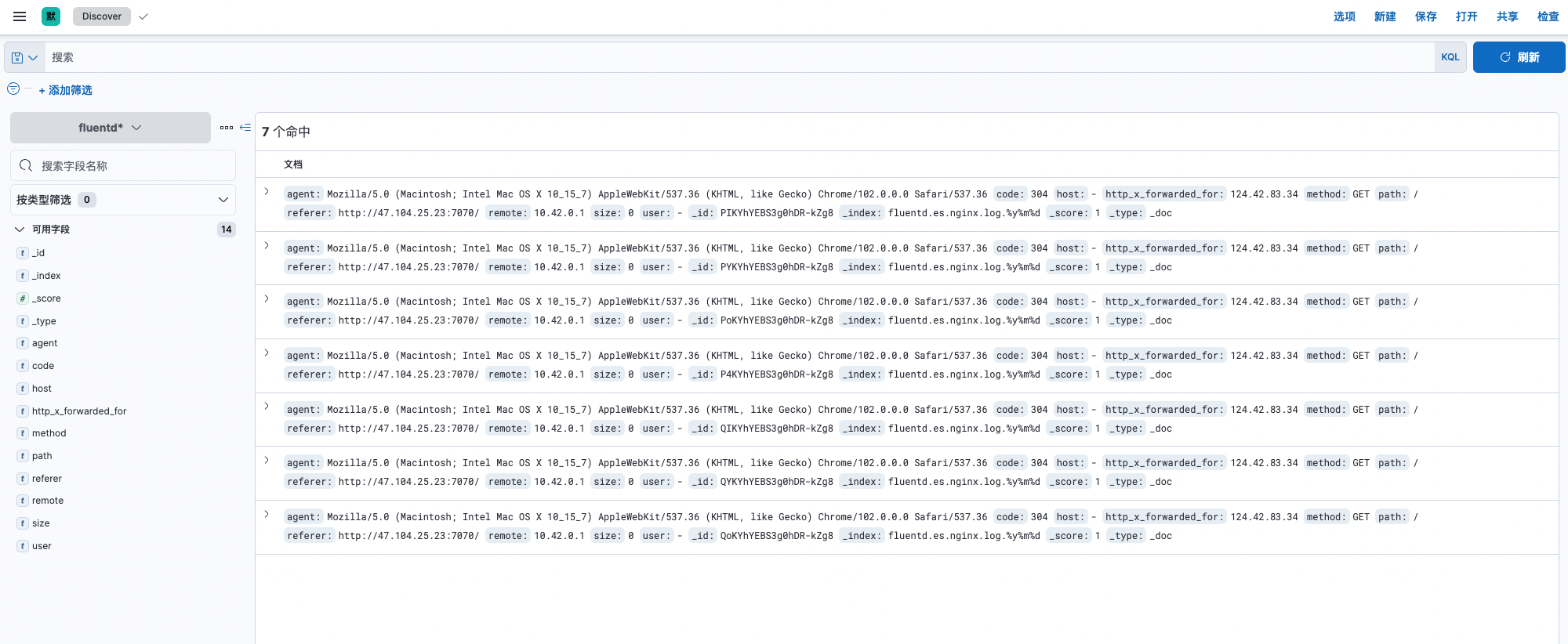

访问

Kibana

面板,进入到 Stack Management -> 数据 -> 索引管理,可以看到已存在的索引名称为

fluentd.es.nginx.log

,

-

访问

Kibana

面板,进入到 Stack Management -> Kibana -> 索引模式,创建索引模式。

-

进入到 Discover,日志正常展示。

3.2 配置文件介绍

配置文件参考 Fluentd 文档

[1]

。

<source>

@type tail

path /var/log/nginx/access.log,/var/log/nginx/error.log

pos_file /var/log/nginx/nginx.access.log.pos

<parse>

@type nginx

</parse>

tag es.nginx.log

</source>

<match es.nginx.**>

@type elasticsearch

log_level info

hosts 127.0.0.1

port 9200

user elastic

password elastic

index_name fluentd.${tag}

<buffer>

chunk_limit_size 2M

queue_limit_length 32

flush_interval 5s

retry_max_times 30

</buffer>

</match>

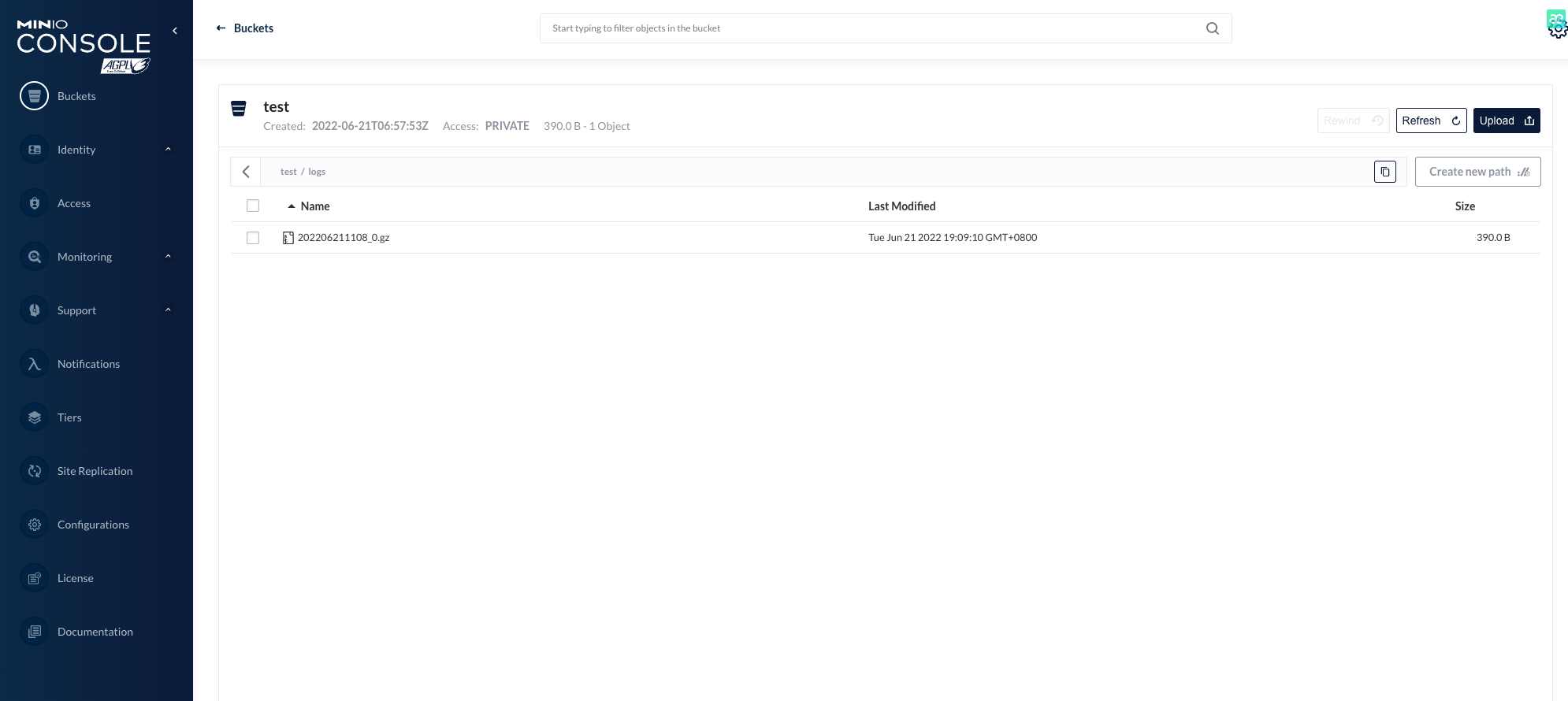

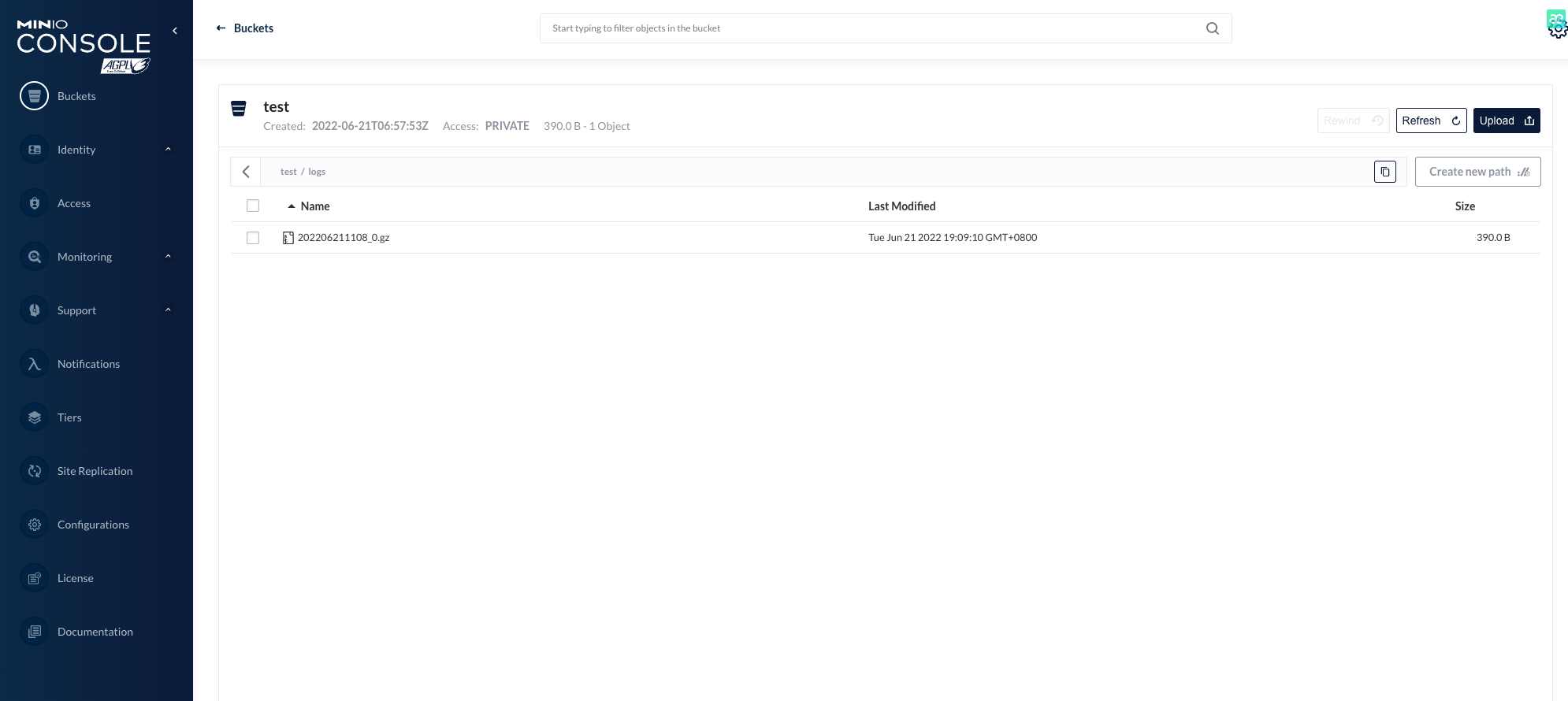

四、Fluentd + Minio 日志收集实践

Fluentd S3 输出插件将日志记录写入到标准的 S3 对象存储服务,例如 Amazon、Minio。

4.1 操作步骤

应用(Minio)和插件(Fluentd S3)都可以通过开源应用商店进行一键部署。

-

对接开源应用商店。在开源应用商店中搜索

minio

,并安装

22.06.17

版本。

-

团队视图 -> 插件 -> 从应用商店安装

Fluentd-S3

插件。

-

访问 Minio 9090 端口,用户密码在 Minio 组件 -> 依赖中获取。

-

基于镜像创建组件,镜像使用

nginx:latest

,并且挂载存储

var/log/nginx

。这里使用

Nginx:latest

作为演示

-

在组件内挂载存储后,插件也会自定挂载该存储,并可访问 Nginx 产生的日志文件。

-

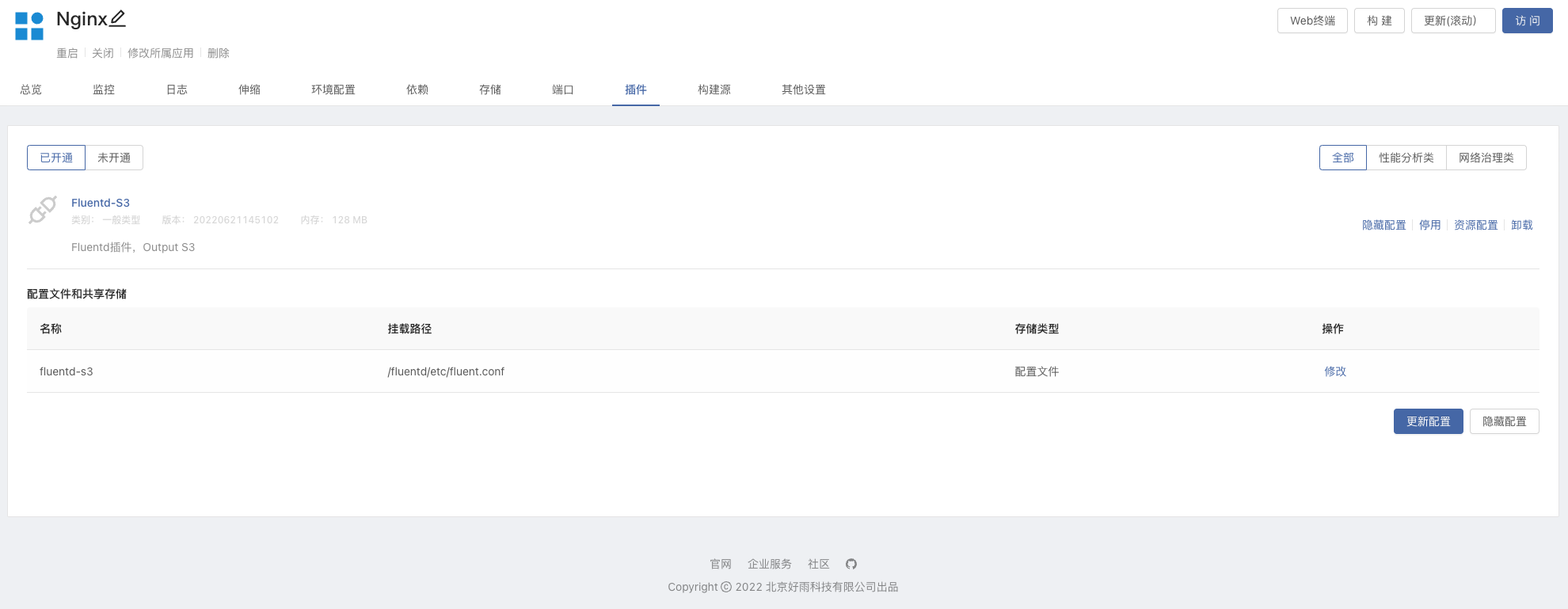

进入到 Nginx 组件内,开通 Fluentd S3 插件,修改配置文件中的

s3_bucket

s3_region

-

建立依赖关系,Nginx 组件依赖 Minio,更新组件使其生效。

-

访问 Nginx 服务,让其产生日志,片刻后就可以在 Minio 的 Bucket 中看到。

4.2 配置文件介绍

配置文件参考 Fluentd 文档

[2]

。

<source>

@type tail

path /var/log/nginx/access.log

pos_file /var/log/nginx/nginx.access.log.pos

tag minio.nginx.access

<parse>

@type nginx

</parse>

</source>

<match minio.nginx.**>

@type s3

aws_key_id "#{ENV['MINIO_ROOT_USER']}"

aws_sec_key "#{ENV['MINIO_ROOT_PASSWORD']}"

s3_endpoint http://127.0.0.1:9000/

s3_bucket test

s3_region en-west-test2

time_slice_format %Y%m%d%H%M

force_path_style true

path logs/

<buffer time>

@type file

path /var/log/nginx/s3

timekey 1m

timekey_wait 10s

chunk_limit_size 256m

</buffer>

</match>

最后

Fluentd 插件可以很灵活的收集业务日志并输出至多个服务,并结合 Rainbond 插件市场的一键安装,让我们的使用变得更加简单、快捷。

目前 Rainbond 开源插件应用市场的 Flunetd 插件只有

Flunetd-S3

Flunetd-ElasticSearch7

,欢迎小伙伴们贡献插件哦!

参考资料

output_elasticsearch:

https://docs.fluentd.org/output/elasticsearch

Apache to Minio:

https://docs.fluentd.org/how-to-guides/apache-to-minio

EFK搭建笔记

因为工作需要需要搭一个日志分析系统,本来打算直接搭 ELK,看了下文档也咨询了下同事,觉得 ELK 可以不过,可能需要改下,使用 EFK 的方式,也就是 es + kafka + kibana 的方式,首先将 数据收到 kafka,在送到es。日志收集工具使用 vector,这个工具也可以将数据从 kafka 送到es。前提就是这么多,开干!

简单易用的监控告警系统 | HertzBeat 在 Rainbond 上的使用分享

在现有的监控告警体系中 Prometheus + AlertManger + Grafana 一直是主流,但对于中小团队或个人来说,这种体系显的较为复杂。而 HertzBeat 能让中小团队或个人很快速的搭建监控告警系统,并通过简单的配置实现应用、数据库、操作系统的监控与告警等。

不得不学!从零到一搭建ELK日志,在Docker环境下部署 Filebeat 日志收集工具

最近在玩 ELK 日志平台,它是 Elastic 公司推出的一整套日志收集、分析和展示的解决方案。

不得不学!从零到一搭建ELK日志,在Docker环境下部署 Kibana 可视化工具

最近在玩 ELK 日志平台,它是 Elastic 公司推出的一整套日志收集、分析和展示的解决方案。