ChatGPT技术路线分析

ChatGPT技术路线分析

三大维度拆解ChatGPT/GPT-4!让巨头们兴奋的技术真相

发源于OpenAI,成名于生成式语言,ChatGPT火得太快了。

2022年11月,OpenAI推出ChatGPT聊天机器人,以对话的形式与用户进行连续性的交互,上线2个月后用户数超过1亿,用户数量增长迅猛。ChatGPT 属于 AIGC 的具体应用,相比过去的 AI 产品,在模型类型、应用领域、商业化等层面也呈现出新的特点。

本期的智能内参,我们推荐东莞证券和华泰证券的报告《大厂加大类 ChatGPT 布局力度,商业应用有望加速落地》《ChatGPT:深度拆解》,解析最近大火的ChatGPT的技术原理和国内商厂布局。报告下载地址: https:// pan.baidu.com/s/1s5MClk 0E8wHezM6WtxoTsQ?pwd=j2ig

01. 发源于OpenAI,成名于生成式语言

OpenAI 是一家世界领先的非营利性人工智能研究公司。OpenAI 于 2015 年在旧金山成立,是一家非营利的人工智能研究公司,公司的目标是以最有可能造福全人类的方式推进人工智能,而不受财务回报需求的约束。OpenAI 创始人背景深厚,由埃隆·马斯克与硅谷孵化器 Y Combinator 投资人山姆·阿尔特曼等人联合创立。公司研究人员经验丰富,包括前Google Brain 研究科学家伊利亚·苏茨凯弗与前 Stripe 首席技术官格雷格·布罗克曼等世界一流研究工程师与科学家。

2018 年,随着特斯拉对 AI 的应用深入,为避免潜在利益冲突,马斯克主动离任董事会,仅保留捐资人和顾问的身份。由于 AI 训练花费金额巨大,2019 年公司从非营利性公司转向部分盈利公司,成立了 OpenAI LP 利润上限子公司,即任何对 OpenAI LP 投资的收益都将统一转移至一家非盈利公司,回报达到投资的 100 倍后进行利润分配。

同年,OpenAI 收到微软注资 10 亿美元,就 Azure 业务开发人工智能技术。2020 年发布 GPT-3 语言模型,由微软获得独家授权。2022 年发布 ChatGPT 的自然语言生成式模型,带来更大潜在应用空间。2023 年,微软拟对 OpenAI 追加数十亿美元投资,利用自身算力基础设施资源发挥与 OpenAI 业务协同效应,深入布局生成式 AI 技术。

2016 年,推出用于开发和比较强化学习算法的工具包 OpenAI Gym,加速公开社会中 RL 研究进度。同时推出 Universe 软件平台,用于测试和训练 AI 在全球游戏、网站和其他应用程序中的智能程度。2019 年,OpenAI 推出深度神经网络 MuseNet,可以使用 4 种不同的乐器生成 10分钟的音乐作品以及最终模型版本的 GPT-2。2020 年,研发团队在 GPT-2 的基础上拓展参数,发布了 GPT-3 语言模型。2021 年,发布了转换器语言模型 DALL·E,从文本描述生成图像。2022 年,OpenAI 在 GPT-3.5 的基础上推出了 ChatGPT,强化了人工智能的语言对话能力,引起社会广泛关注。

▲OpenAI 产品

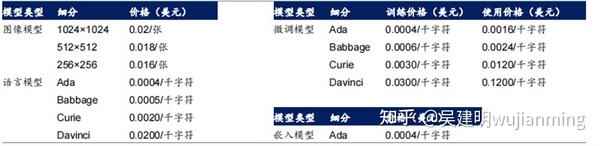

OpenAI 当前盈利主要通过付费 API 接口,并尝试拓展盈利模式。目前,OpenAI 提供 GPT-3、Codex 以及 DALL·E 的 API 数据接口,分别执行用户自然语言任务、自然语言转换为代码的任务以及创建和编辑图像的任务。API 接口根据类型不同以流量收费,比如图像模型以分辨率分类按张数收费,语言模型则以基于的子模型型号按字符数收费。OpenAI API 盈利情况较好,据路透社数据,OpenAI 2022 年收入数千万美元,公司预计 2023 与 2024 年收入分别为 2 亿美元和 10 亿美元。同时,OpenAI 正尝试拓展自身盈利模式,2023 年 1 月试点推出订阅制 ChatGPT Plus,收取每月 20 美元的会员费以得到各类优先服务。

▲OpenAI API 价格

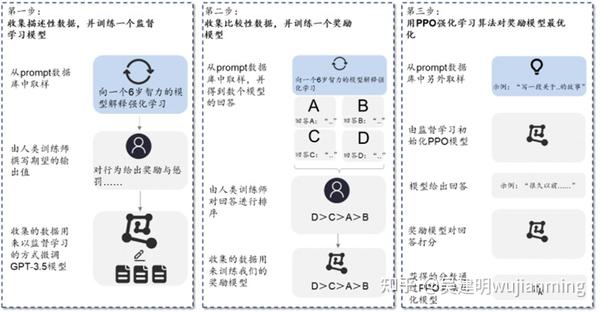

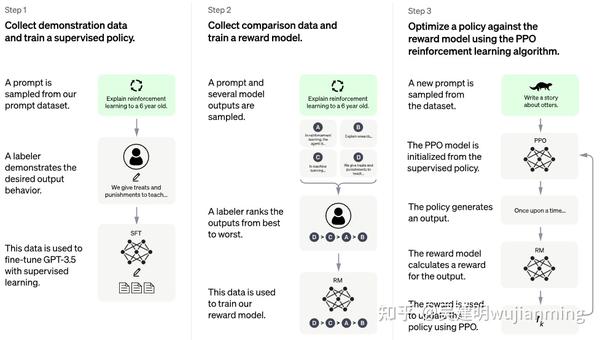

ChatGPT 使用来自人类反馈的强化学习 (RLHF) 来训练该模型。首先使用监督微调训练了一个初始模型:人类 AI 训练员提供对话,他们在对话中扮演双方——用户和 AI 助手。其次,ChatGPT 让标记者可以访问模型编写的建议,以帮助他们撰写回复。最后,ChatGPT 将这个新的对话数据集与原有数据集混合,将其转换为对话格式。具体来看,主要包括三个步骤:

1)第一阶段:训练监督策略模型。在 ChatGPT 模型的训练过程中,需要标记者的参与监督过程。首先,ChatGPT 会从问题数据集中随机抽取若干问题并向模型解释强化学习机制,其次标记者通过给予特定奖励或惩罚引导 AI 行为,最后通过监督学习将这一条数据用于微调 GPT3.5 模型。

2)第二阶段:训练奖励模型。这一阶段的主要目标,在于借助标记者的人工标注,训练出合意的奖励模型,为监督策略建立评价标准。训练奖励模型的过程同样可以分为三步:1、抽样出一个问题及其对应的几个模型输出结果;2、标记员将这几个结果按质量排序;3、将排序后的这套数据结果用于训练奖励模型。

3)第三阶段:采用近端策略优化进行强化学习。近端策略优化(Proximal Policy Optimization)是一种强化学习算法,核心思路在于将 Policy Gradient 中 On-policy 的训练过程转化为Off-policy,即将在线学习转化为离线学习。具体来说,也就是先通过监督学习策略生成 PPO模型,经过奖励机制反馈最优结果后,再将结果用于优化和迭代原有的 PPO 模型参数。往复多次第二阶段和第三阶段,从而得到参数质量越来越高的 ChatGPT 模型。

▲ChatGPT 模型原理

从 ChatGPT 的训练原理中,我们不难发现,这一训练过程存在几个特点:

1)采用的是单一大模型。在 GPT 模型兴起之前,大多数 AI 模型主要是针对特定应用场景需求进行训练的小模型,存在通用性差、训练数据少、适应范围小的弊端。而我们看到,ChatGPT 虽然在过程中使用了奖励模型等辅助手段,但最终用于实现自然语言理解和生成式功能的主模型只有一个,但却在语义理解、推理、协作等方面表现出了更强能力。因此,ChatGPT 的成功,验证了参数增长、训练数据量增大,对 AI 模型的重要意义。

2)采用的是小样本学习方法。在小样本学习(Few-shot Learning)方法下,AI 预训练模型在不必使用大量标记的训练数据,就可以建立起比较通用的泛化能力。简单来说,小样本学习即是在给定有限信息和较少训练数据的情况下,尝试对总体规律进行理解和预测,这一过程类似于“学习如何去学习”。对于小样本学习在 ChatGPT 中的应用,我们认为,这一方法解决了大模型数据标注工作量巨大的问题,是模型得以迅速迭代的基础。

3)采用人类反馈微调监督学习。ChatGPT 是从 GPT3.5(即 InstructGPT)改进而来的版本,相比于前代,ChatGPT 主要变化在于采用了人类反馈机制,对监督学习过程进行微调。本质上来说,无论是大模型还是小样本学习,解决的目标都是提升训练的效率,但真正令ChatGPT 实现结果准确、合理的关键技术,还是在于加入了人类反馈。据 Long Ouyang等人 2022 年发表的《Training language models to follow instructions with humanfeedback》,InstructGPT 仅用 13 亿个参数就实现了比 1750 亿个参数的 GPT-3 更优的输出解雇,显著提升了真实性、减少了有害信息的输出。

02. 三大维度拆解GPT模型特征

拆解 GPT 模型可以帮助理解 ChatGPT 之所以强大的原因。从前面的讨论中,我们发现,ChatGPT 的成功离不开 AI 大模型的加持,强大的算法训练模型,使得 ChatGPT 在迭代中获得实现接近自然语言的表达能力。而这一切的核心,都来自一个模型:GPT 模型。因此,以 GPT 模型为核心,从三个维度出发去拆解 GPT 模型,以此进一步挖掘 ChatGPT 强大背后的原因。

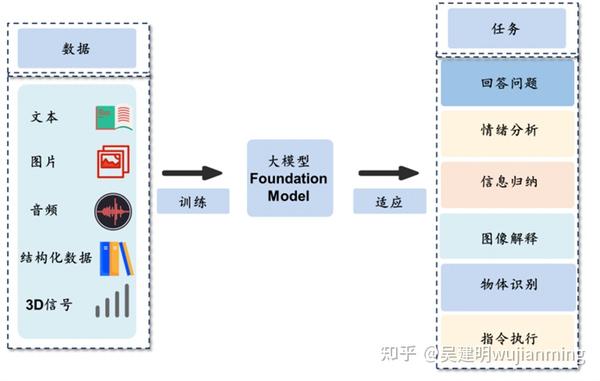

维度一:单一大模型:ChatGPT 使用单一大模型,积累强大底层通用能力。对于 ChatGPT 所用到的训练模型,从模型体量来看,属于 AI 单一大模型的范畴。对比传统 AI 训练模型,单一大模型的“大”体现在:1)更多的模型参数量;2)更大的数据处理量;3)更大的训练计算量。模型体量的增大,带来的最直接变化,在于 AI 模型通用能力的跨越式提升。传统的 AI 训练方法,大多以单一知识领域的应用为目标,主要使用特定领域有标注的数据进行模型训练,模型通用性差,如果更换使用场景,往往需要进行重新训练。而大模型的训练,一是能使用的数据来源更加广泛,可用数据量更大;二是对标注要求更低,只需要对数据进行微调甚至不调就可以用于训练;三是输出的能力更加泛化通用,在语义理解、逻辑推理、文本表达等方面能力更出众。

从通用到特殊,单一大模性具备丰富的垂直领域应用潜力。基于对底层能力的训练,AI 大模型积累了对于数据背后特征和规则的理解,因此在进行垂直领域的时候,可以做到“举一反三”。这一过程,与人类学习知识的过程类似,都是先学习如何去学习,再构建听说读写能力,最后在不同学科深入探索。AI 大模型也是一样,在完成通用能力积累之后,可以将学习能力移植到需要应用的特定领域,通过投喂垂直领域数据,可以使模型达到目标场景所需的性能。

▲单一大模性具备丰富的垂直领域应用潜力

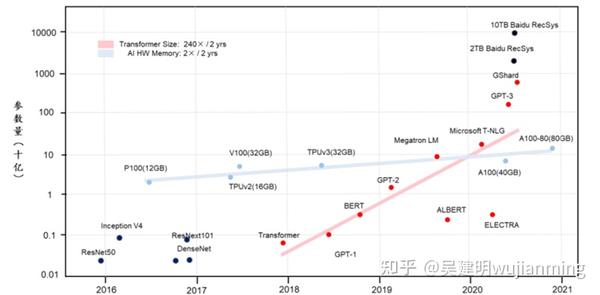

从大模型自身的发展过程来看,参数量的变化是一个非常值得关注的指标。从最早的 ResNet、Inception 等模型,到如今的 GPT,模型参数量不断增长。2018 年前后 OpenAI 先后推出 Transformer 和GPT-1 模型,参数量来到 1 亿级别。随后谷歌提出 3 亿参数的 BERT 模型,参数量再次增长。2019、2020 年,OpenAI 加速追赶,陆续迭代出 GPT-2、GPT-3 模型,参数量分别为15 亿、1750 亿,实现模型体量质的飞跃。另一方面,参数运算需要大规模并行计算的支持,核心难点在于内存交换效率,取决于底层 GPU 内存容量。以英特尔为例,从 2017 年 V100的 32GB 内存到 2020 年 A100 的 80GB 内存,GPU 内存容量的提升量级与模型参数相比显然不在同一量级。而 ChatGPT 的解决方法,则是与微软联手,借助 Azure 强大的基础算力设施,为 ChatGPT 提供训练支持。

▲单一大模型的参数量快速增长

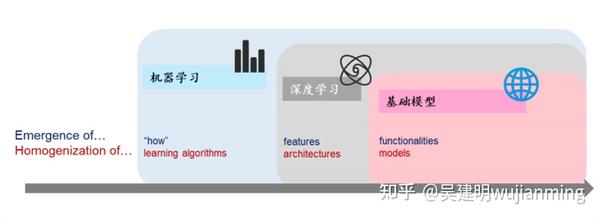

2021 年 8 月,李飞飞等学者于 arXiv 发表《On the Opportunities and Risk of Foundation Models》,将大模型统一命名为 Foundation Models,即基础模型或基石模型。此外,论文还提出基础模型面临的两大问题:1)同质化。尽管基础模型基于标准的深度学习和迁移学习,但其规模导致了新能力的涌现,其在众多任务中的有效性激励了同质化的产生;2)特性涌现。尽管基础模型即将被广泛部署,但目前研究者对其如何工作、何时失效以及其涌现的特性衍生了何种能力尚缺乏清晰的理解。举例来看,如机器学习的引入,使得算法从数据案例中学会了如何执行(自动推断);深度学习的引入,涌现了用于预测的高级特征;基础模型的引入,涌现了上下文学习等高级功能。但在这一过程中,机器学习使学习算法变得同质化(例如,逻辑回归),深度学习使模型架构同质化(例如,卷积神经网络架构),大模型使得下游模型同质化(例如,下游模型一定会继承上游模型缺陷)。

从本质上来说,上下游模型同质化的问题无法被完全解决,OpenAI 选择的方向是尽可能填补缺陷漏洞。从 GPT-3.5版本开始,OpenAI 团队在模型中引入了监督学习过程。在监督学习模式下,人类反馈机制开始加入到模型训练过程,从而不断纠正模型生成结果,逐步提升输出结果的准确性和真实性。随着大模型朝着越来越符合人类期望的方向演进,对话逻辑和表达方式逐渐逼近人类水平,才最终达到我们今天所看到的样子。

▲基础模型带来特性涌现和模型同质化

通过拆解单一大模型的原理、特征及发展历程,我们发现单一大模型的引入,是 ChatGPT 强大语言的根本来源。展望未来,我们认为ChatGPT 或将在大模型加持下加速迭代,主要因为:1)大模型训练效果取决于数据量,目前 ChatGPT 仅使用 2021 年之前的数据,随着更多数据的加入,模型底层语言能力有望进一步加强;2)大模型具备能力迁移潜力,垂直领域应用或将加速 ChatGPT 进化;3)OpenAI 背靠微软,大算力资源为模型演进提供保障;4)随着软件用户规模持续扩张,用户自身的反馈又会带来类似监督学习的效果,或将带动 ChatGPT 加速迭代。基于此,看好 AI 大模型及 ChatGPT 未来应用前景,商业化落地或将加快。

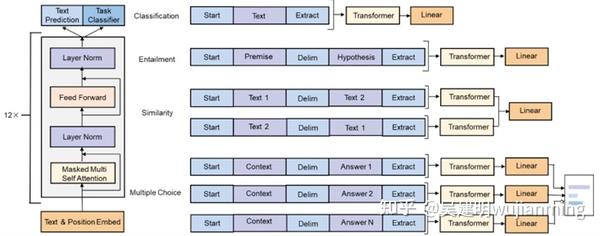

维度二:预训练语言模型。拆解模型来看,主要关注预训练语言模型和 Transformer 特征抽取器。前面讨论了ChatGPT 背后所使用的 AI 大模型及其迭代过程,但如果我们将拆解动作继续深入,在更细颗粒度的视角下,其实可以将训练模型做进一步的拆解。实际上,GPT(General Pre-Training)即通用预训练语言模型,简单来说就是一种利用 Transformer 作为特征抽取器,基于语言模型进行预训练的模型。因此,接下来我们从模型的两个关键特征出发,分别从预训练语言模型和 Transformer 特征抽取器的角度来分析 GPT 模型的迭代过程。

预训练语言模型无需人工标签,为 NLP 研究带来质变。预训练属于迁移学习的范畴,其思想是在利用标注数据之前,先利用无标注的数据,即纯文本数据训练模型,从而使模型能够学到一些潜在的跟标注无关的知识,最终在具体的任务上,预训练模型就可以利用大量的无标注数据知识,标志着自然语言处理模型进入了大规模复制阶段。从实现原理上来看,预训练语言模型是通过计算某个词句 w 的出现概率,即 p(W),在给定词句的情况下,可以自行计算出后一个词或句出现的概率。因此,GPT 的训练可以在无人工标签的基础上进行,通过连续不断地预测、迭代参数、再预测,模型最终实现语言能力的学习。

在大多数基于统计方法和神经网络的自然语言处理模型中都需要大量已标注的数据集来满足模型训练,但并非所有的训练任务都能获取足够的标注信息。同时,随着模型复杂度和参数数量的增加,大多数数据集的大小难以支持训练。而预训练模型能先通过利用无标注的数据训练模型,解决传统模型无法解决的实际问题。而且由于预训练语言模型可以利用现实世界中大量的纯文本数据训练,扩大了其训练范围和规模,拥有发掘大模型(Foundation Models)的潜力。

第一代预训练模型是静态词向量模型,经训练给每一个词赋予静态词向量,让相似的词聚集在一起,实现了符号空间到向量空间的映射,经典结构有 Continuous Bag-of-Words(CBOW)和 Skip-Gram(SG)等。而由于第一代模型的词向量静态性,使其不能结合上下文,进而有无法分辩同义词等缺陷。最新的第二代预训练模型,包括 BERT、GPT 等则在此基础上允许静态词向量与上下文交互,这种动态词向量优化了同义词问题。目前,第二代预训练模型的标准范式是“预训练+微调”:首先在大量的文本上训练出一个预训练语言模型,再根据实际情况对得到的预训练语言模型进行微调,加强了模型对下游应用场景的契合度。

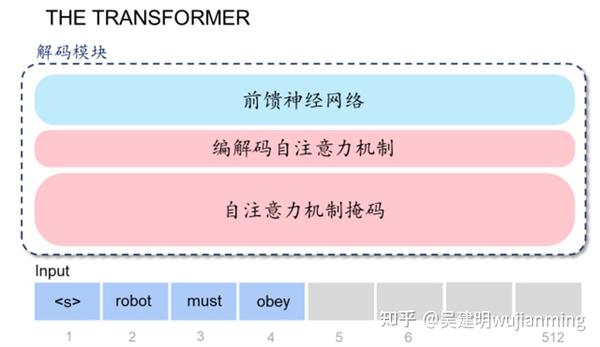

维度三:Transformer 特征抽取器。Transformer 是大模型高效运行的根基。前面我们从单一大模型出发,对预训练语言模型进行了 。但如果我们继续深入,会发现语言模型仍然不是 GPT 模型的最底层,语言模型之下还需要有具体的调度架构和运算逻辑,来实现最终的计算。我们认为,Transformer特征抽取器在 GPT 模型中,就承担了这样的一个角色,直接决定了 AI 大模型能否实现高效率的运算和学习。

Transformer 模型最早由谷歌在 2017 年提出,属于深度学习模型架构的一种,特点是在学习中引入了注意力机制。对比循环神经网络(RNN)来看,Transformer 与 RNN 均对输入数据,如自然语言等,进行顺序处理,并主要应用于翻译和文本摘要等工作。但 Transformer 与 RNN 不同的是,Transformer 中的注意机制可以为输入序列中的任何字符提供上下文,因此可以一次处理所有输入,而不是一次只处理一个词。因此,与 RNN 相比,Transformer 可以实现更大规模的并行计算,大大减少了模型训练时间,使得大规模 AI 模型得以被应用。

▲Transformer 解码模块拆解

在 GPT 模型中,解码模块相当于基本架构单元,通过彼此堆叠的方式,拼凑成最终我们看到的 GPT 模型底层架构。这里有两个值得关注的要点:1)解码模块的数量决定了模型的规模,GPT-1 一般有 12 个模块,GPT-2有 48 个,GPT-3 则有 96 个模块;2)针对模块输出的结果还需要进行 Finetune(对模型进行调优)。

▲解码模块堆叠形成 GPT 模型完整架构

03.

生成式AI应用于创造性工作

AI 可分为生成式 AI 和分析型 AI,其中分析型 AI(Analytical AI),主要在给定数据的情况下,通过分析找出规律和关系,并在此基础上生成报告或给出建议。比如通过追踪客户行为以刻画用户画像,并基于此进行个性化推荐,实现精准营销;通过收集城市中传感器的大量数据并分析,预测天气及环境污染情况,从而帮助相关部门进行政策制定。不同于分析型 AI 局限于分析已有内容,生成式 AI(Generative AI)可以通过学习已有数据和信息生成多种形式的新的内容,在创造性工作的领域进行应用,目前生成式 AI 的应用主要包括生成文本、图像、对话、音视频、代码、3D 等。

▲生成型 AI 应用领域

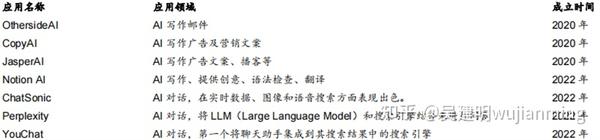

ChatGPT 通过学习大量语料并通过生成模型生成文本回答,其基础 GPT-3 是一个大型语言模型。该模型通过对大量语料的预训练,学习了语言的语法、语义、语用等特征,并通过对语言的生成任务进行微调,以适应各种应用场景。目前,除了 ChatGPT 外,有大量 AIGC 应用产品基于 GPT-3 模型。

▲基于 GPT-3 的 AI 产品

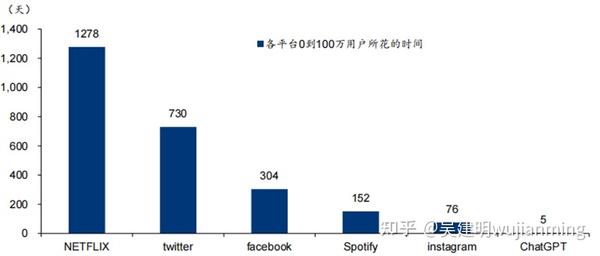

据各公司官网,ChatGPT 从 0 到 100 万用户数仅花费 5 天,速度远超其他平台。从活跃用户角度,据Similarweb,2023 年 1 月期间,ChatGPT 平均每天约有 1300 万独立访客,超出 22 年 12月一倍。用户数量的快速扩大反映了 ChatGPT 具备较强的商业化潜力。

▲ChatGPT 从 0 到 100 万用户速度远超其他平台

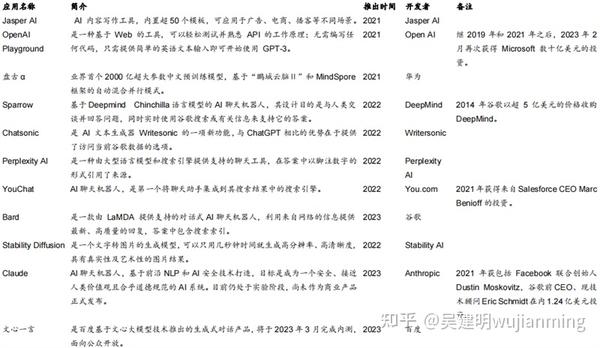

AIGC(AI Generated Content)指由人工智能生成的内容,包括文本、图像、音频、3D 等多种类型,具有高效及自动化生产的特点。近年来谷歌、亚马逊、百度等国内外巨头持续布局 AIGC。2014 年,谷歌以超 5 亿美元的价格收购人工智能公司 DeepMind;2023 年 3 月,谷歌宣布向人工智能初创公司 Anthropic 投资约 3 亿美元,建立新的合作伙伴关系;2022 年 11 月,亚马逊宣布与 AI 制图平台 Stability AI 合作,成为其首选云合作伙伴,同时为其提供亚马逊 Tradium 芯片;2021 年 4 月,华为诺亚方舟实验室联合多部门推出首个 2000 亿参数中文预训练模型盘古α;2023 年 2 月,百度官宣类 ChatGPT 大模型新项目文心一言(英文名 ERNIE Bot)。

▲AIGC 领域产品

微软发布基于 OpenAI 模型的全新搜索引擎 Bing 和 Edge 浏览器。在 FY23Q2 电话会议上,微软表示将增加对 ChatGPT 的支持,使得客户能够很快在自己的应用程序上调用它。随后,公司宣布扩大与 OpenAI 的合作伙伴关系,将向 OpenAI 进行一项为期多年、价值数十亿美元的投资,以加速其在人工智能领域的技术突破。2 月 7 日,公司召开发布会推出基于新的 OpenAI 模型搜索引擎 Bing 和 Edge 浏览器,将搜索、浏览器、聊天功能结合起来,用户既可以选择传统搜索结果与聊天对话框并排显示,也可以选择直接与聊天机器人进行对话。在新版的 Bing 之下,用户搜索直接给出答案,而非网页链接,结果相关性更强、更加智能化。目前新版 Bing 已经开放有限预览,预计在未来几周推出移动版本。

谷歌、百度积极跟进,商业应用有望加速。1 月 27 日,美国数字媒体公司 BuzzFeed 率先宣布计划使用 OpenAI 提供的技术来协助创作个性化内容。谷歌方面,近期向 OpenAI竞争对手之一的 Anthropic 投资约 3 亿美元,获得该公司 10%股份,Anthropic 将用投资从谷歌的云计算部门购买大量计算资源;2 月 6 日,谷歌透露计划推出一款聊天机器人 Bard 以应对 ChatGPT,该服务将开放给受信任的测试人员,并在未来的几周向更广泛的公众开放服务。百度方面,2 月 7 日宣布将推出类 ChatGPT 项目文心一言(英文名为ERNIE Bot),预计将在 3 月份完成内测,面向公众开放。随着微软将 ChatGPT 整合至自身产品中,谷歌、百度等 AI 领军企业也宣布推出聊天机器人,未来有望将聊天机器人整合至搜索引擎甚至办公软件等业务当中,商业化应用有望加速落地。

ChatGPT的正式发布,标志着人工智能再也不是“人工智障”。随着 AI 与下游场景加快融合,同时叠加政策对行业支持,国内 AI 市场规模有望持续高增。到 2026 年,我国人工智能核心产业规模有望达到 6,050 亿元,20-26 年复合增速为 25.01%;并由此带动的相关产业规模将超过 2 万亿元。

还在为玩不了ChatGPT苦恼?这十几个开源平替也能体验智能对话

MLNLP 社区是国内外知名的机器学习与自然语言处理社区,受众覆盖国内外NLP硕博生、高校老师以及企业研究人员。

社区的愿景 是促进国内外自然语言处理,机器学习学术界、产业界和广大爱好者之间的交流和进步,特别是初学者同学们的进步。

将为大家盘点一下 ChatGPT 的开源平替项目。

距离 ChatGPT 的最初发布,过去差不多四个月的时间了。在这期间,ChatGPT 的惊艳表现,让人直呼 AIGC 是不是要提前实现了。

不过众所周知的一个秘密是,ChatGPT 不大可能开源,加上巨大的算力投入以及海量的训练数据等,都为研究界复制其实现过程设下重重关卡。

面对 ChatGPT 的来势汹汹,开源平替是一个不错的选择,它们在实现相似功能的同时,还能让你通过替代品了解 ChatGPT 的运行机理。

随着技术的进步,现在已经出现了许多其他类似于 ChatGPT 的新 AI 模型。本文我们将为大家盘点一下 ChatGPT 的开源平替项目。内容将分为两部分,一部分为类 ChatGPT 开源项目汇总,另一部分是对该项目汇总的补充。

项目汇总

项目作者 nichtdax 整理了 9 个开源的 ChatGPT 平替项目。接下来会一一介绍。

项目地址: https:// github.com/nichtdax/awe some-totally-open-chatgpt

PaLM-rlhf-pytorch

第一个项目是「PaLM-rlhf-pytorch」,项目作者为 Phil Wang。该项目是在 PaLM 架构之上实现 RLHF(人类反馈的强化学习),它基本上是使用 PaLM 的 ChatGPT。

该项目已在 GitHub 上获得了 5.8k 的 Stars。

项目地址: https:// github.com/lucidrains/P aLM-rlhf-pytorch

下图为训练流程。

OpenChatKit

第二个项目是「 OpenChatKit 」,它提供了一个强大的的开源基础,为各种应用程序创建专用和通用的聊天机器人。该 kit 包含了一个经过指令调优的 200 亿参数语言模型、一个 60 亿参数调节模型和一个涵盖自定义存储库最新响应的可扩展检索系统。

OpenChatKit 是在 OIG-43M 训练数据集上训练的,该数据集是 Together、LAION 和 Ontocord.ai 三者的联合。项目作者表示,这不仅仅是一个模型的发布,还是一个开源项目的开始。他们正在发布一套工具和流程,并通过社区贡献持续改进。

该项目已在 GitHub 上获得了 5.7k 的 Stars。

项目地址: https:// github.com/togethercomp uter/OpenChatKit

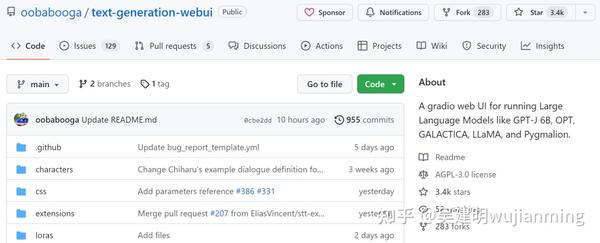

text-generation-webui

第三个项目是「text-generation-webui」,它是一个用于运行 GPT-J 6B、OPT、GALACTICA、LLaMA 和 Pygmalion 等大语言模型的 gradio web UI。该项目旨在成为文本生成领域的 AUTOMATIC1111/stable-diffusion-webui。

功能包括使用下拉菜单在不同模型之间切换、提供类似于 OpenAI playground 的笔记本模式、用于对话和角色扮演的聊天模式、为 GPT-4chan 生成漂亮的 HTML 输出等等。

该项目已在 GitHub 上获得了 3.4k 的 Star。

项目地址: https:// github.com/oobabooga/te xt-generation-webui

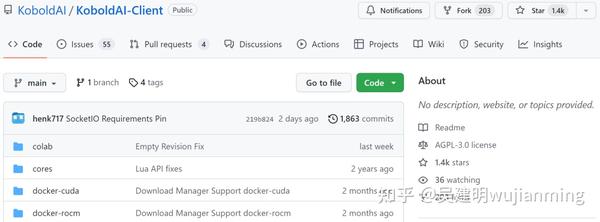

KoboldAI-Client

第四个项目是「KoboldAI-Client」,它是一个基于浏览器的前端,通过多个本地和远程 AI 模型实现 AI 辅助写作。

KoboldAI-Client 提供了一系列标准的工具,包括内存、作者注释、世界信息、保存 & 加载、可调节的 AI 设置、格式化选项以及导入现有文字冒险游戏《AI Dungeon》的能力。你可以开启 Adventure 模式,也可以玩 AI Dungeon Unleashed 之类的游戏。

该项目已在 GitHub 上获得了 1.4k 的 Stars。

项目地址: https:// github.com/KoboldAI/Kob oldAI-Client

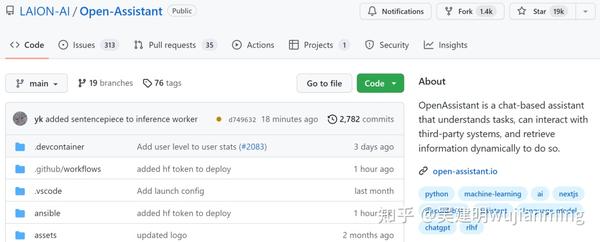

Open-Assistant

第五个项目是「Open-Assistant」,它旨在让每一个人都可以访问基于聊天的大语言模型。项目作者希望借此在语言创新方面掀起一场革命,就像 stable diffusion 帮助世界以新的方式创造艺术和图像一样。

项目作者计划收集高质量人工生成指令执行样本(指示 + 响应),目标大于 50k。对于收集到的每个指示,他们将采样多个补全结果。接下来进入基于指示和奖励模型的 RLHF 训练阶段。

该项目已在 GitHub 上获得了 19k 的 Stars。

项目地址: https:// github.com/LAION-AI/Ope n-Assistant

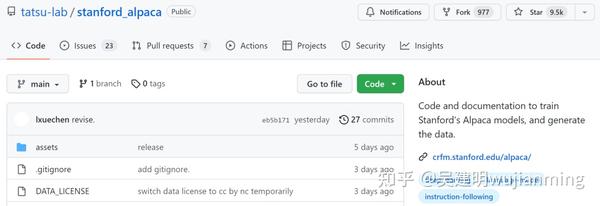

stanford_alpaca

第六个项目是「stanford_alpaca」,它旨在建立和共享一个指令遵循的 LLaMA 模型。该 repo 包含了用于微调模型的 52k 数据、用于生成数据的代码以及用于微调模型的代码。

该项目已在 GitHub 上获得了 9.5k 的 Stars。

项目地址: https:// github.com/tatsu-lab/st anford_alpaca

ChatRWKV

第七个项目是「ChatRWKV」,它类似于 ChatGPT,但由 RWKV(100% RNN)模型支持,并且是开源的。项目作者表示,RWKV 是目前唯一能在质量和扩展方面媲美 transformers 的 RNN 模型,同时速度更快、节省 VRAM。

该项目已在 GitHub 上获得了 3.5k 的 Stars。

项目地址: https:// github.com/BlinkDL/Chat RWKV

ChatGLM-6B

第八个项目是由清华技术成果转化的公司智谱 AI 开源、支持中英双语的对话语言模型「ChatGLM-6B」,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。

ChatGLM-6B 使用了和 ChatGPT 相似的技术,针对中文问答和对话进行优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答。

不过由于 ChatGLM-6B 的规模较小,目前已知其具有相当多的局限性,如事实性 / 数学逻辑错误、可能生成有害 / 有偏见内容、较弱的上下文能力、自我认知混乱、以及对英文指示生成与中文指示完全矛盾的内容。

该项目已在 GitHub 上获得了 6k 的 Stars。

项目地址: https:// github.com/THUDM/ChatGL M-6B

xmtf

第九个项目是「xmtf」,包含了创建论文《Crosslingual Generalization through Multitask Finetuning》中介绍的 BLOOMZ、mT0 和 xP3 的所有组件。

其中 BLOOMZ 是一个 1760 亿参数且可开放获取的多语言模型;mT0(这里特指谷歌的 T5X);xP3 是 46 种语言的有监督数据集,带有英语和机器翻译的 prompts。

项目地址: https:// github.com/bigscience-w orkshop/xmtf

除了上述提到的模型,ChatGPT 平替项目还包括基于 Meta 开源的大模型系列 LLaMA (Large Language Model Meta AI)的一些研究,这个系列模型的参数量从 70 亿到 650 亿不等。具有 130 亿参数的 LLaMA 模型「在大多数基准上」可以胜过 GPT-3( 参数量达 1750 亿),而且可以在单块 V100 GPU 上运行;而最大的 650 亿参数的 LLaMA 模型可以媲美谷歌的 Chinchilla-70B 和 PaLM-540B。

论文链接: https:// research.facebook.com/p ublications/llama-open-and-efficient-foundation-language-models/

GitHub 链接: https:// github.com/facebookrese arch/llama

基于此研究,开发者也提出了几个开源项目。

llama.cpp 无需 GPU,就能运行 LLaMA llama.cpp 项目实现了在 MacBook 上运行 LLaMA,还有开发者成功的在 4GB RAM 的树莓派上运行了 LLaMA 7B。总结而言,即使开发者没有 GPU ,也能运行 LLaMA 模型。

项目地址: https:// github.com/ggerganov/ll ama.cpp ChatLLaMA 由于 LLaMA 大模型系列没有使用 RLHF 方法,因此初创公司 Nebuly AI 开源了 RLHF 版 LLaMA(ChatLLaMA)的训练方法。它的训练过程类似 ChatGPT,该项目允许基于预训练的 LLaMA 模型构建 ChatGPT 形式的服务。与 ChatGPT 相比,LLaMA 架构更小,但训练过程和单 GPU 推理速度更快,成本更低;该库还支持所有的 LLaMA 模型架构(7B、13B、33B、65B),因此用户可以根据训练时间和推理性能偏好对模型进行微调。

项目地址: https:// github.com/nebuly-ai/ne bullvm/tree/main/apps/accelerate/chatllama 期待后续更多开源项目加入进来。

参考链接: https://www. reddit.com/r/MachineLea rning/comments/11uk8ti/d_totally_open_alternatives_to_chatgpt/

参考文献链接