搞懂函数的区别的最好方法就是产看函数的底层实现。

首先可以在pytorch中分别点击进入函数内部,看他们的具体实现。

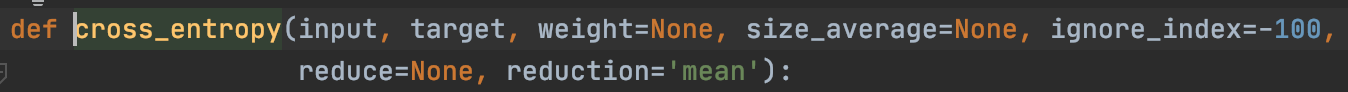

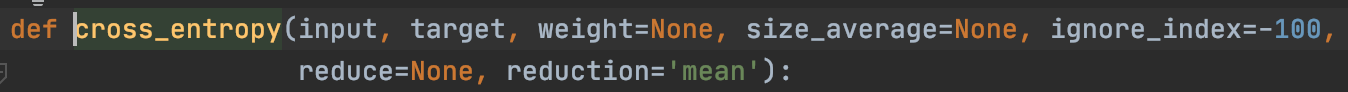

1、F.cross_entropy的内部实现是:

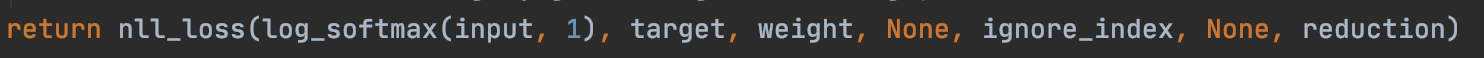

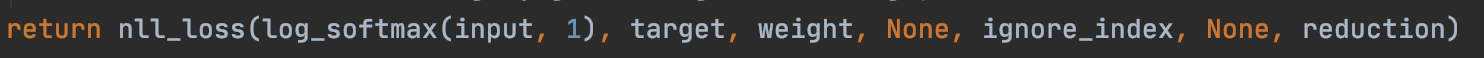

并且cross_entropy函数的返回值是:

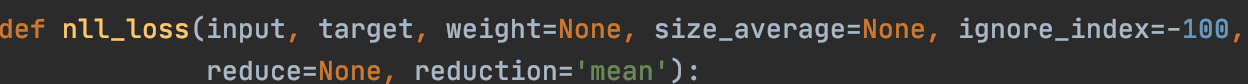

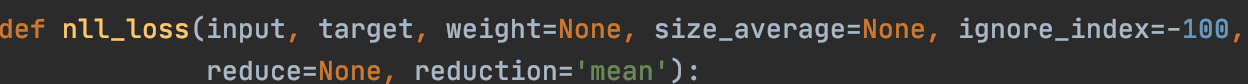

2、F.nll_loss的内部实现是:

3、结论

这里先上结论。这两种损失的区别在于input上的操作,对于cross_entropy来说,他首先会对

input进行log_softmax

操作,然后再将log_softmax(input)的结果送入nll_loss;而nll_loss的input就是input。

NLLLoss 的 输入 是一个对数(log)概率(softmax)向量和一个目标标签. 它不会为我们计算对数概率. 适合网络的最后一层是log_softmax.

损失函数 nn.CrossEntropyLoss() 与 NLLLoss() 相同, 唯一的不同是它为我们去做 log_softmax.

4、实验验证

input = torch.tensor([[[[0.5546, 0.1304, 0.9288],

[0.6879, 0.3553, 0.9984],

[0.1474, 0.6745, 0.8948]],

[[0.8524, 0.2278, 0.6476],

[0.6203, 0.6977, 0.3352],

[0.4946, 0.4613, 0.6882]]]])

target = torch.tensor([[[0, 0, 0],

[0, 0, 0],

[0, 0, 1]]])

loss = F.cross_entropy(input, target)

print(loss)

input = F.softmax(input, dim=1)

input = torch.log(input)

loss = F.nll_loss(input, target)

print(loss)

5、总结:

利用nll_loss实现的cross_entropy和pytorch中自带的cross_entropy的结果一致,证明函数的却别仅在input上的处理,F.cross_entropy也是基于F.nll_loss实现的。

注:如有错误还请指出!

搞懂函数的区别的最好方法就是产看函数的底层实现。首先可以在pytorch中分别点击进入函数内部,看他们的具体实现。1、F.cross_entropy的内部实现是:并且cross_entropy函数的返回值是:2、F.nll_loss的内部实现是:3、结论这里先上结论。这两种损失的区别在于input上的操作,对于cross_entropy来说,他首先会对input进行log_softmax操作,然后再将log_softmax(input)的结果送入nll_loss;而nll_loss的inpu

常用于多分类任务,NLLLoss 函数输入 input 之前,需要对 input 进行 log_softmax 处理,即将 input 转换成概率分布的形式,并且取对数,底数为 e

class torch.nn.NLLLoss(weight=None, size_average=None, ignore_index=-100,

reduce=None, reduction='...

在计算loss的时候,最常见的一句话就是tf.nn.softmax_cross_entropy_with_logits,那么它到底是怎么做的呢?

首先明确一点,loss是代价值,也就是我们要最小化的值

tf.nn.softmax_cross_entropy_with_logits(logits, labels, name=None)

除去name参数用以指定该操作的name,与方法有关的一共两个参数:

第一个参数logits:就是神经网络最后一层的输出,如果有batch的话,它的大小就是[batchsize,num_classes],单样本的话,大小就是num_classes

第二个参数lab

一文搞懂F.cross_entropy的计算过程

交叉熵是在分类任务中常用的一种损失函数,本文详细介绍了pytorch中是如何实现交叉熵的细节!!!

pytorch中的交叉熵函数为F.cross_entropy(input, target),本文以变化检测或语义分割中用到的数据模型为例:input的维度为[batchsize,classes,width,height],target的维度为[batchsize,width,height]。

1. 随机生成模型数据

input = torch.rand([1

F.nll_loss计算方式是下式,在函数内部不含有提前使用softmax转化的部分;

nn.CrossEntropyLoss内部先将输出使用softmax方式转化为概率的形式,后使用F.nll_loss函数计算交叉熵。

CrossEntropyLoss()=log_softmax() + NLLLoss()

两个函数的输入分别是input和target,

input是网络预测的输出,形状为(batch_size, pro),其中pro为class的个数;

target是标签,不

F.cross_entropy(x,y)

cross_entropy(x,y)是交叉熵损失函数,一般用于在全连接层之后,做loss的计算。

其中x是二维张量,是全连接层的输出;y是样本标签值。x[batch_size,type_num];y[batch_size]。

cross_entropy(x,y)计算结果是一个小数,表示loss的值。

x = np.array([[1, 2,3,4,5],#共三3样本,有5个类别

[1, 2,3,4,5],

# 随机新建3个样例数据,每个样例数据包含4个属性特征

input = torch.randn(3,4)

tensor([[ 0.0054, -0.8030, -0.5758, -0.6518],

[-0.5518, 0.3904, 0.5296, 0.4973],

[ 0.1608, 0.5822, 0.9536, -0.3173

nn.CrossEntropyLoss() 与 NLLLoss()

NLLLoss 的 输入 是一个对数概率向量和一个目标标签. 它不会为我们计算对数概率. 适合网络的最后一层是log_softmax. 损失函数 nn.CrossEntropyLoss() 与 NLLLoss() 相同, 唯一的不同是它为我们去做 softmax.

CrossEntropyLoss()=log_softmax() + NLLLoss()

参考链接:

(3条消息) CrossEntropyLoss与NLLLoss的总.

损失函数,又叫目标函数,是编译一个神经网络模型必须的两个参数之

一。另一个必不可少的参数是优化器。损失函数是指用于计算标签值和预测值之间差异的函数,在机器学习过程中,有多种损失函数可供选择,典型的有距离向量,绝对值向量等。

上图是一个用来模拟线性方程自动学习的示意图。粗线是真实的线性方程,虚线是迭代过程的示意,w1 是第一次迭代的权重,w2 是第二次迭代的权重,w3 是第三次迭代的权重。随着迭代次数的增加,我们的目标是使得 wn 无限接近真实值。,pytorch 中定义了很多类型的预定义损失函数,

F.binary_cross_entropy_with_logits 是 PyTorch 中的一个函数,用于计算二分类问题中的交叉熵损失。它的输入是模型的输出和真实标签,其中模型的输出是经过 sigmoid 函数处理后的 logits(即未经过激活函数的值),真实标签是一个0/1值的张量。该函数的计算公式为:

loss = -1/n * sum(y * log(sigmoid(x)) + (1-y) * log(1-sigmoid(x)))

其中 n 表示样本数,y 表示真实标签,x 表示模型的输出。这个函数将 logits 作为输入,而不是将 sigmoid 函数应用于 logits。这是因为在计算交叉熵损失时,sigmoid 函数的作用已经被包含在函数内部了。使用 F.binary_cross_entropy_with_logits 可以避免数值计算上的不稳定性,并且可以提高训练的效率。