一是查看字体的软件 FontCreator,支持 window 。

链接:https://pan.baidu.com/s/1tUznnSB3siI2rVY9Whv88A 密码:ygz9

二是打开字体的网站,适合 mac 系统的朋友使用。

先通过 cloudconvert 把字体文件转化为 svg 后再用 fontello 打开查看

http://fontello.com/

https://cloudconvert.com/ttf-to-svg

如果嫌弃上面转换太过麻烦可以用百度字体打开。

http://fontstore.baidu.com/static/editor/index.html

推荐使用 FontCreator 以及百度字体。

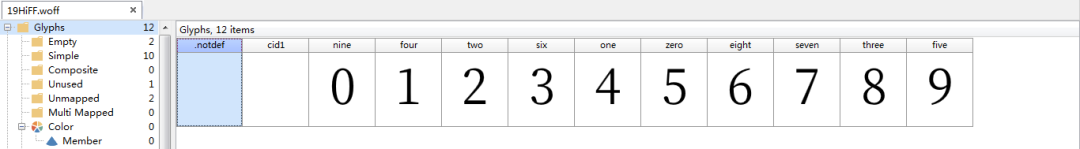

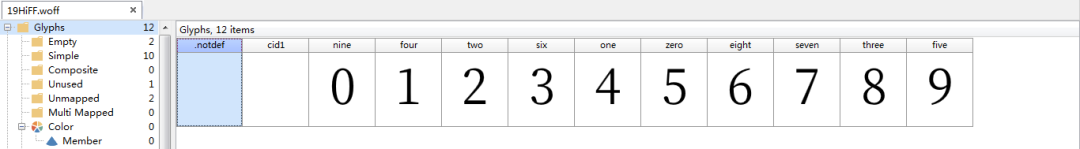

打开后显示的样子与下图类似。

其实这个流程最大的问题就是我们人工录入的基本字体的字典数据有可能是会发生变化的,这就导致我们后面还要手动去改。

来源:https://cuiqingcai.com/6431.html

https://mp.weixin.qq.com/s/is1ScEk4cl5r8_uuEz5Jmw

目前已知的几个字体反爬的网站是猫眼,汽车之家,天眼查,起点中文网等等。本文用到的第三方库fontTools安装pip install fontTools或者到这个地址下载:https://files.pythonhosted.org/packages/81/d5/d6b345845163f6563c86748e82b9c6077e7ee21ab0289ad8a27a23985f6f...

一·字体反爬原理

🧾 🧾 Python字体反爬原理是指爬虫在爬取网站数据时,遇到了基于字体反爬的防护措施。这种反爬措施是通过将网站的文字转换成特定的字体文件,然后在页面上引用该字体文件来显示文字,使得爬虫无法直接获取文字内容。

🧾 具体原理如下:

网站将需要显示的文字转换成特定的字体文件,通常是TrueType或OpenType格式的字体文件。

网站在页面上引用该字体文件,并使用CSS样式将需要显示的文字的字体设置为该字体文件。

爬虫在获取页面源代码时,无法直接获取到需要显示的文字内容,只能获

题目链接:http://glidedsky.com/level/crawler-font-puzzle-1

我们首先看一下这道题与之前的题目有什么不同,前面的几道题不管用了哪种反爬手段,都是可以直接从源代码中提取数字的,但是这道题却不可以。将光标放到数字上,右键选择检查元素,可以看到数字的源码,源代码中显示的数字和我们在网页中看到的数字并不相同,且每次刷新页面时,网页上的数字不变,源代码中的数字会发生变化,因此本题的字体是动态映射的,无法通过事先构造映射表的方式来爬取。

爬虫遇到的问题

最近在用爬虫程序爬一些网站的时候发现爬到的数据出现乱码,不能正常显示:

如上图我们可以发现有些数据的数字变成了加密字体,我就去查看了一下网站的代码,结果发现网站的代码显示是这样的:

原来有些网站上使用了字体加密技术,为了解决这个问题,我找了大量的资料,可是网上的很多方法由于网站反爬技术的进步或者网站更新了字体加密规则已经不能使用了,于是我就开始了破解字体加密的艰辛历程。

解决方法...

2.爬取频率控制:适量控制爬取频率,使爬虫不会频繁地访问和抓取网站数据。

3.IP代理和User-Agent伪装:使用IP代理和User-Agent伪装,使得爬虫难以被检测和封锁。

4.验证码识别:应对特别严格的反爬虫措施,需要进行验证码识别。

5.数据去重:避免爬取重复数据,减少对网站负荷的压力。

6.合理的爬取深度:避免过深地爬取网站数据,减少风险。

总的来说,反反爬措施需要根据网站反爬虫的措施而定,通过模拟真实用户行为、IP代理伪装等手段提高爬虫抓取数据的成功率和新鲜度。