上周自己有使用Kaggle平台运行项目的需求,查阅了一些文章,结合自己的实践经验写了此文章,将使用Kaggle平台运行项目并查看下载日志文件的过程详细记录了下来,一些注意事项也写了,希望能够帮助到大家。

一、上传项目

第一步:创建notebook

第二步:上传项目和数据集

第三步:进行设置,打开GPU

第四步:运行项目

二、查看运行结果、下载日志文件

第一步:更改日志文件保存路径

第二步:查看日志文件

第三步:下载日志文件

一、上传项目

第一步:创建notebook

1、点击左上角

File

2、点击

New Notebook

,就可以创建一个新的notebook了。

第二步:上传项目和数据集

(建议将项目和数据集分开上传,因为无法在kaggle平台上实时更改代码,上传之后代码是只读形式的,想要修改代码只能在平台以外修改,改完之后再重新上传。为了节省上传时间,可以把数据集放到单独一个文件夹里,这样修改代码之后只上传代码就行啦~)

1、点击右上角

Add data

,出现下图。

2、点击第一行右边的

Upload

,出现下图。将项目文件夹或者zip文件拖动过来,等待上传就好了。

(需要搭梯子才能上传成功)

上传完成之后,需要命名,

要注意名字之前不能使用过。

2、点击第一行右边的

Upload

,出现下图。将项目文件夹或者zip文件拖动过来,等待上传就好了。

(需要搭梯子才能上传成功)

上传完成之后,需要命名,

要注意名字之前不能使用过。

3、上传完成之后,点击右下角的

Create

。

如果之前上传过这个项目,更改部分代码之后再次上传,会出现一些重复文件,此时上传完成之后右下角不是

Create

了,而是

Skip duplicates

,如图所示,如果不再想要重复的文件,直接点击

Skip duplicates

即可,上传之后整个项目的文件数量会减少。如果不想跳过重复文件,

点击右下角的方块

,选择第二个“Include duplicates”,这样就把更改代码之后的整个项目上传上去了。

第三步:进行设置,打开GPU

1、打开右侧一栏的Settings,在Accelerator中选择GPU,即将CPU打开。

如果是第一次使用kaggle平台,Settings里面没有这一项,需要先添加。

注意到下面有个GPU Quota,是显示已经使用了GPU的时长。一个账号每个星期有36小时的使用时间,超过这个时间就不能用了。

另外还有限制,只能连续跑9个小时,项目没有跑完也会中断,中断之后就没有输出结果了,前面等于白跑。

如果项目运行时间会超过9小时,建议将epoch缩小,如果一共要跑100轮,可以分成两次,一次跑50轮,第一次跑完之后保存模型,再接着跑50轮,就能解决连续运行项目时长不够的问题了。

第四步:运行项目

路径非常重要!!!

1、编写运行语句。

!python '../input/pointnet1649/wjypointnet2/train_cls.py'

‘’里面是训练文件的路径。在右侧找到文件,可以直接复制文件路径。

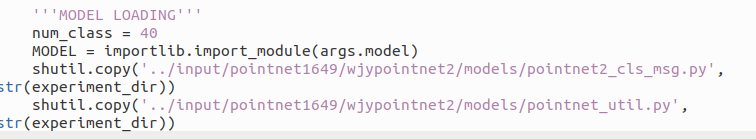

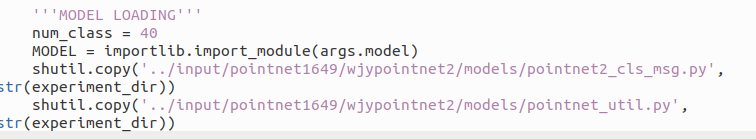

一定要注意更改代码里调用的模型路径,否则运行会报错。

下图是我的项目目录。

下图是我训练文件中更改的模型路径。

2、点击右上角Save Version,出现下图。

3、点击右下角Save,程序即可运行。

一定要选择Save&Run All,

将模型保存下来,这样才能继续训练,并且查看日志文件。

二、查看运行结果、下载日志文件

第一步:更改日志文件保存路径

一定要更改代码里的日志文件保存路径,将其放到/kaggle/working/下。

下图是我训练文件代码,代码第二行更改了路径,其他都没有改。

下图是运行完成的项目,从Home里右侧Your Datasets里可以找到所有保存运行的项目。点击项目名称,进入项目主页,点击Code->Your Work,出现项目,点击进入下图页面。可以看到右侧Output中已经存在输出日志了。如果路径不正确,Output中就没有文件。

第二步:查看日志文件

第二步:查看日志文件

1、在上图页面点击Notebook,往下滑即可看到日志文件。

第三步:下载日志文件

1、在上图页面点击Logs,出现下图。

2、点击右侧Download Logs,即可下载日志文件。

上周自己有使用Kaggle平台运行项目的需求,查阅了一些文章,结合自己的实践经验写了此文章,将使用Kaggle平台运行项目并查看下载日志文件的过程详细记录了下来,一些注意事项也写了,希望能够帮助到大家。一、上传项目第一步:创建notebook 1、点击左上角File 2、点击New Notebook,就可以创建一个新的notebook了。第二步:上传项目和数据集 (建议将项目和数据集分开上传,因为无法在kaggle平台上实时更改...

1.每次上传dataset都要上传rar

文件

,且上传后无法编辑修改源

文件

,想修改只能再次完整上传。

2.注意用pip安装其他版本的软件包时(如scipy由1.7.1到1.2.1).应先安装包再

查看

版本,否则

查看

的版本还是原来未重新安装时的版本。

3.整个

文件

目录为:

如何保存训练好的模型

通过tf.saved_model.save(netwok, path)

其中network代表你的模型的实例化,path自己定义路径,(记住path保存没有

文件

格式,只需要给出路径,例如“./model\my_model”

tf.saved

torch.save(model.state_dict(),'./model_best.pth')

一般情况下,以上语句保存的模型在

kaggle

的output/

kaggle

/working

文件

夹下

建议将效果较好的模型下载保存,否则网页休眠之后之前训练的结果就都么得了

我这里使用的模型是经过预训练的resnet50

model = torchvision.models.segmentation.fcn_resnet50(pretrained= False,progress= True

最近想训练一个模型,奈何自己电脑的GPU太拉胯根本带不动,用cpu跑跑一整天才跑完一个epoch,真的心累,于是乎,我把目光投向了云GPU。然后

kaggle

的云GPU瞬间吸引了我的目光,好家伙,不要钱还好操作,这波羊毛难道不薅?!冲冲冲!!!

kaggle

官网: 地址

(一)注册

虽说薅羊毛很快乐,但是刚开始薅的时候还是要花点儿功夫的,注册的时候我就折腾了一会儿。

1.点击右上角“Register”注册

2.选择邮箱

3.人机验证

这里一直让我填写验证码:Captcha must be filled out

使用 GPU 加速深度学习的训练是很关键的,对于缺少计算资源的人来说,在

Kaggle

上使用 GPU 训练模型是一个相对不错的体验。但是,如果,你的

输出结果

是图片,那该如下将训练后的图片下载到本地呢?

我尝试了很多办法,最终想到一个相对不错的点子:将输出的图片打包为 ZIP

文件

。具体操作如下:

上传需要训练的模型与数据(以 ZIP 的形式):https://www.

kaggle

...

2、点击第一行右边的

Upload

,出现下图。将项目文件夹或者zip文件拖动过来,等待上传就好了。

2、点击第一行右边的

Upload

,出现下图。将项目文件夹或者zip文件拖动过来,等待上传就好了。

第二步:查看日志文件

第二步:查看日志文件