-

从data文件夹中读取每一个text文件并分词

-

用TextRank4Keyword类对文本进行分词并提取关键词,并将提取出的关键词写到output文件夹中的同名文件中

-

读取output中的关键词文件,并建立词向量统计词频

-

将统计出的词频写入到Word frequency.txt文件中

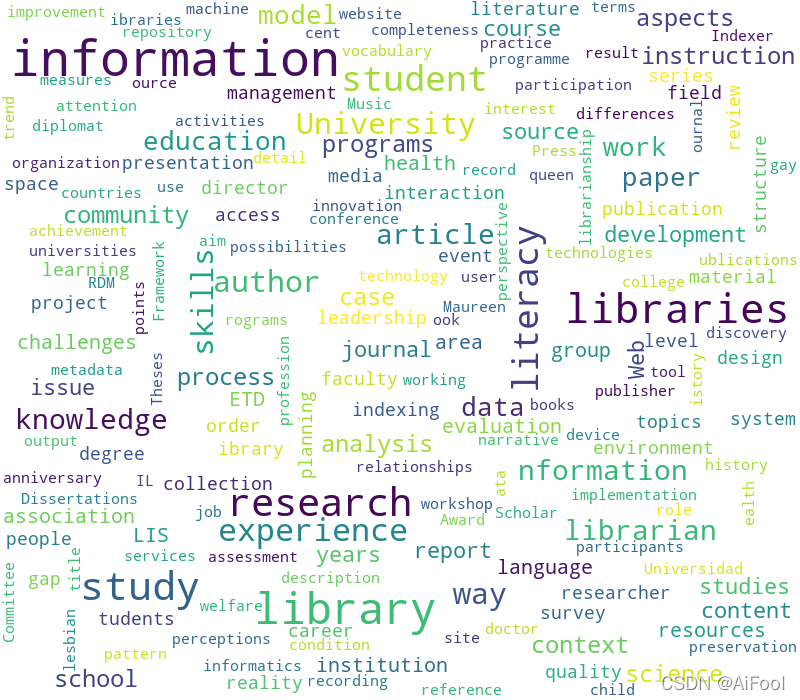

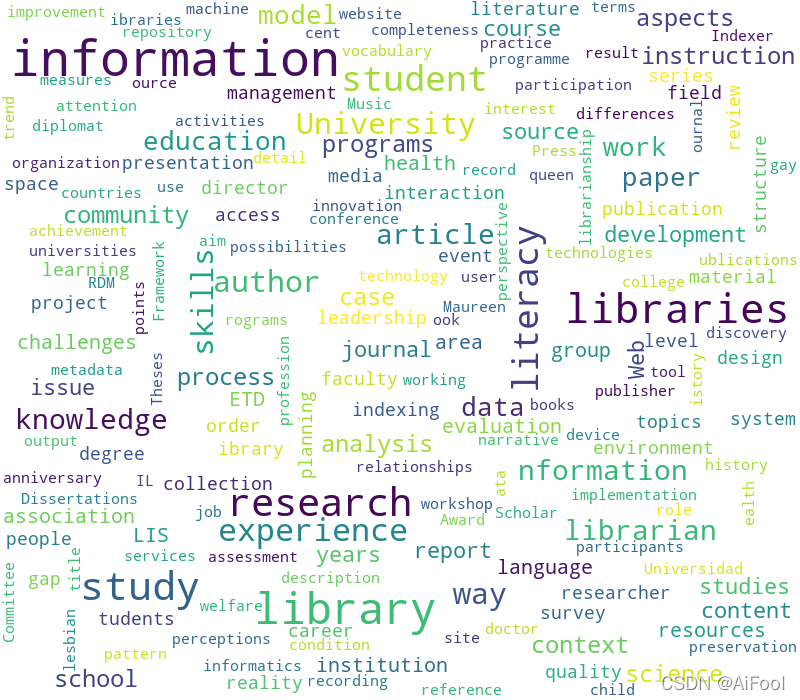

import os

from wordcloud import WordCloud

if __name__ == '__main__':

rootdir = 'output'

list = os.listdir(rootdir)

wordsdic=''

for i in range(0, len(list)):

path = os.path.join(rootdir, list[i])

if os.path.isfile(path):

tempf=open(path,mode='r',encoding='utf-8')

temptext=tempf.read()

onelist=str(temptext[1:-1]).split(",")

for onew in onelist:

wordsdic=wordsdic+','+onew

wc = WordCloud(

background_color="white",

max_words=300,

min_font_size=15,

max_font_size=50,

width=800,

height=700

wc.generate(wordsdic)

wc.to_file("words_cloud.png")

完整代码:https://download.csdn.net/download/Datapad/67637102

LZ的同事写的文章经常被公司或者上级部门发表,LZ对此觉得同事写的文章一定有什么套路或者经常使用的词句,所以LZ收集了6篇同事的文章希望统计出其文章的高频词语以此可以效仿。

2020.05.13更新:大家点个赞再收藏吧(点赞后观看,养成好习惯)TAT如你所见。文章标题图是以 周杰伦的百度百科 词条为分析文档,以 周杰伦超话第一的那张图+PPT删除背景底色 为词频背景进行制作的(PPT真是个巨强的软件!我以后有时间一定会和大家分享的!)。这种词频分析、尤其是这种词云图,在这两年流行了起来。但大家在制作的过程中可能总会这样或那样的问题:配色单调、收费、对中文的适配很差等等...

爱奇艺《青春有你2》评论数据爬取,并对评论中的词频进行统计以及对评论进行健康情感审查随着《青春有你2》的热播,你有没有被那些漂亮的小姐姐吸引呢?作为一个发际线已经到后脑勺的程序员,小姐姐的舞姿、歌声那些都是浮云。你想不想知道每期节目,观众评论最多的内容是什么?评论的内容是否健康呢?通过这篇博客,我将手把手教你如何实现。需要的配置和准备工作1、中文分词需要jieba2、词云绘制需要wordcloud...

目录前言一、Linux的一些常用命令?二、Python的一些常用操作三、常用的一些自然语言处理工具包1、nltk工具包2、四、常用的一些分词模型1、朴素贝叶斯2、N-gram模型总结

在开始进行NLP的相关任务时,首先需要做一些预备工作,比如说数据清洗、提取等,接下来就让我们来看一下具体有哪些操作吧。

一、Linux的一些常用命令?

wc -l file: 看文件一共有多少行

more file: 观察部分文件

head -10 file: 查看文件的前10行内容

更多Linux命令请查看我的另一篇

f=open('d:/八十天环游地球.txt','r')

f2=open('d:/八十天环游地球new.txt','w')

f3=open('d:/八十天环游地球-章节.txt','w')

for i in f:

i=i.rstrip() #去掉右端空格

i=re.sub('&l

前一篇文章讲述了分类算法的原理知识级案例,包括决策树、KNN、SVM,并通过详细的分类对比实验和可视化边界分析与大家总结。本文将详细讲解数据预处理、Jieba分词和文本聚类知识,这篇文章可以说是文本挖掘和自然语言处理的入门文章。两万字基础文章,希望对您有所帮助。欢迎大家来到“Python从零到壹”,在这里我将分享约200篇Python系列文章,带大家一起去学习和玩耍,看看Python这个有趣的世界。所有文章都将结合案例、代码和作者的经验讲解,真心想把自己近十年的编程经验分享给大家,希望对您有所帮助,文章中不

本次实验一共有三个要求,统计高频词、分析词性以及画出词云,在词性分析部分为了使结果更加直观还绘制了一个饼状图用来统计最多的十种词的占比。实验用的文本文件是实验二的爬取评论结果,为了方便便直接将实验二生成的文件拿过来使用了,在文本中有许多的非中文字符(符号、表情包、数字、字母),一开始的时候是针对这个文本专门写了一个函数除去该文本中的非中文字符,再将结果存入一个新的文本“实验文本”,此后的操作便一直使用这个文本进行,但是在做完之后觉得只能局限性太大了,于是便上网查询了一下,知道了可以用正则表达式来解决这个问题