VICUNA是一个开源GPT项目,对比最新一代的chat gpt4.0, 已经达到了它90%的能力。并且,我们可以把它安装在自己的电脑上!

这期视频讲的是,如何在自己的电脑上面安装开源的GPT模型VICUNA。

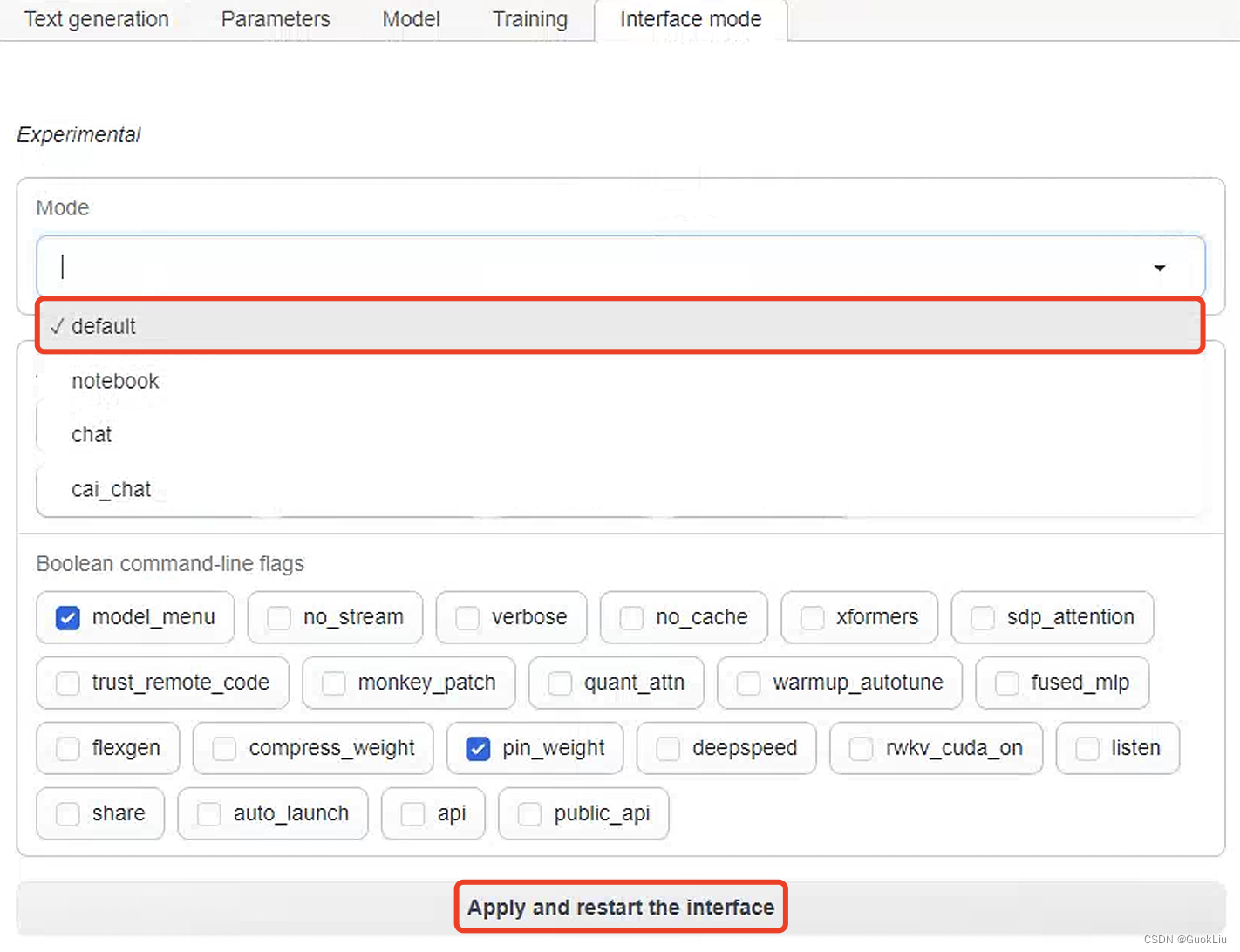

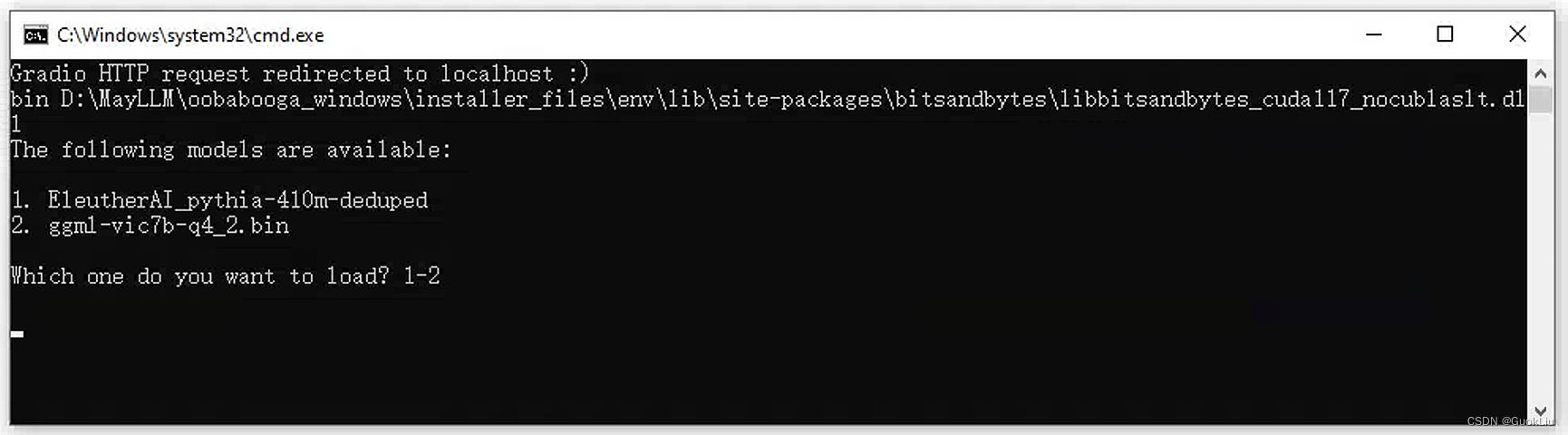

除此之外,我们还将给GPT模型配置一个友善的可视化界面 - OOBABOOGA!在上面可以聊天,训练,培养劳拉模型。。。

https://github.com/lm-sys/FastChat

https://www.notion.so/90-ChatGPT-VICUNA-OOBABOOGA-WEBUI-8ef428d225eb449a90982892b3827497

1. 安装过程中途发生问题,中途退出或者无法继续安装:

删除oobabooga-windows文件夹里面的installer_files文件夹。点击install.bat重新安装;

2. WEBUI运行之后,出现Expecting value: line 1 column 1 (char 0),通常是因为开了代理。把代理关闭,重新启动start-webui.bat

3. webui可以正常进入,但是聊天时,电脑终端(CMD)提示 RuntimeError: CUDA out of memory。

修改start-webui.bat文件,以下这行,多加一个参数(--pre_layer 20),但是这样回答速度会变慢:

call python server.py --auto-devices --cai-chat --wbits 4 --groupsize 128 --pre_layer 20

GPT4ALL V.2重大升级 | CPU运行,商业许可证、一键安装、新UI、基于GPT-J新模型

https://youtu.be/A7PidEyuDRc

开源AUTO-GPT:自主管理功能的GPT-4!| WINDOWS电脑安装和功能展示!

https://youtu.be/Y0mYusN-kPI

90%的ChatGPT功能?|CPU运行VICUNA开源人工智能模型 | WINDOWS电脑安装

https://youtu.be/tJa_AdSIWd4

在本地电脑运行的ChatGPT | 克隆大型GPT训练模型- 适用于 Mac/Windows/Linux | 基于LLAMA & GPT-3.5-TURBO开源项目

https://youtu.be/dlLZUV_SHQE

这个全新发布的Lamini引擎,大大拉低了模型训练的门槛,开发者人手一个ChatGPT的梦想成真了。

快速定制模型的LLM引擎Lamini来了,开发者狂喜!

ChatGPT虽好,但始终有门槛。通常,只有拥有AI博士学位的大型机器学习团队,才能这样训练一个模型。

为了把这个门槛打下来, 团队构建了Lamini引擎,从此,每个开发者都能够拥有从GPT-3训练ChatGPT的超能力!

划重点:可以商用!可以商用!可以商用!

Lamini的开发团队表示,你需要的只是几行代码,就可以用托管数据生成器俩训练自己的LLM,包括权重和其他所有的内容。

此外,你也可以使用开源的LLM,用Lamini库对生成的数据进行微调。以及访问完整的LLM训练模块,使用从LoRa等速度优化,到虚拟私有云 (VPC) 部署等企业功能。

对此,英伟达科学家Jim Fan表示, LLaMa+自定义数据正在成为新的范式,而Lamini的推出也带了一种全新的模式——FaaS,微调即服务。

MLOps的未来是「LMOps」。哪里有标准化,哪里就有机会。

OpenAI科学家,前特斯拉人工智能总监Andrej Karpathy

GPT-4发布后,微软人工智能研究人员发表了一篇论文,称OpenAI语言模型展示了通用人工智能(AGI)的“火花”。

GPT-4是OpenAI最新的大型语言模型(LLM),在对其公开发布进行微调之前,研究人员可以访问其不受限制的版本六个月。“通用人工智能的火花:GPT-4的早期实验”是微软机器学习基础团队在与GPT-4合作将其与Bing搜索引擎集成时所做观察的结果。研究人员澄清说,这只是朝着越来越智能的系统迈出的第一步,并强调他们的研究是基于GPT-4的早期版本。

AGI的概念,是计算世界中一个备受争议的话题,实际定义有时也很模糊。目前的人工智能可以被描述为狭义的,因为它是由机器学习模型组成的,这些模型是为执行特定功能而设计的。

微软的研究人员认为,GPT-4比以前的模型表现出更多的通用智能。他们声称GPT-4特别擅长在没有特定训练的情况下执行各种任务,并在数学和编码等领域取得了接近人类水平的表现。在这项研究中,该团队基于“推理、计划、解决问题、抽象思考、理解复杂想法、快速学习和从经验中学习的能力”来定义智能,他们说AGI指的是展示这些广泛智能能力的系统。

论文摘要揭示了作者的印象:“

GPT-5 是 OpenAI 发布的下一个主要 LLM(大型语言模型)。鉴于ChatGPT的巨大成功,OpenAI 正在继续推进为其人工智能聊天机器人提供动力的未来模型的开发。

GPT-5 旨在成为对GPT-4 的重大改进,尽管人们对此知之甚少。这是迄今为止传闻的所有内容。

OpenAI 在其 LLM 上继续取得快速进展。GPT-4 于 2023 年 3 月 14 日首次亮相,距 GPT-3.5 与 ChatGPT 一起推出仅四个月。

OpenAI 已正式表示,GPT-4.5 将在“2023 年 9 月或 10 月”推出,作为“GPT-4 和即将推出的 GPT-5 之间的中间版本”。

至于 GPT-5,有传言称培训将在今年 12 月完成,这将使其可能在 2024 年的某个时候发布。

我们还没有看到 OpenAI 将如何对新模型的可用性进行分级。目前,GPT-3.5 在 ChatGPT 中可用,而 GPT-4 为ChatGPT Plus保留。然而,我们可以假设 GPT-5 将首先进入 ChatGPT Plus。这些更高级的模型是否会渗透到免费的 ChatGPT 工具

最近,大型语言模型 (LLM) 在各种跨领域任务中表现出强大的性能,但在处理化学相关的问题上却举步维艰。此外,LLM 缺乏外部知识来源,限制了其在科学研究中的应用。来自洛桑联邦理工学院(EPFL)和罗切斯特大学的研究人员开发了 ChemCrow,一种 LLM 化学智能体,旨在完成有机合成、药物发现和材料设计等各种任务。通过集成 13 种专家设计的工具,ChemCrow 增强了 LLM 在化学方面的表现,并出现了新的功能。该研究通过 LLM 和专家人工评估,证明了 ChemCrow 在自动化各种化学任务方面的有效性。令人惊讶的是,作为评估器的 GPT-4 无法区分明显错误的 GPT-4 completions 和 GPT-4 + ChemCrow 性能。该研究以「ChemCrow: Augmenting large-language models with chemistry tools」为题,于 2023 年 4 月 11 日发布在 arXiv 预印上。在过去几年中,LLM 通过自动化自然语言任务改变了各个领域。然而,LLM 往往难以完成看似简单的任务,例如基础数学和化学操作。AI 已

拾象一直关注本轮范式转移的头部公司 OpenAI,以及大模型给行业带来的影响。海外

独角兽在社群内举办了一系列优质线上闭门讨论会,本次为系列讨论会的第三场,主题

是在 3 月 15 日发布的多模态预训练大模型 GPT-4。

围绕 GPT-4,我们集中讨论了以下几个问题:

1. 对模型能力演变和边界的思考:包括 GPT-4 发布后有哪些新技术导入、解锁了哪

些新能力、带来哪些新机会、从应用/算力/infra/研究上的变化,以及未来的演变走

向、关键要素、带来哪具体的影响/案例/新机会,还有 LLM 的能力边界;

2. 对 AI Native Apps 的思考:包括应用 LLM 的什么好案例、什么特点、关键要素是

什么、看好哪些垂类应用、壁垒,应该怎么做 AI Native Apps 等;

3. 对模型格局的思考:OpenAI 一家独大,还是多寡头,模型和应用的关系,垂直应

用都要拥有自己的模型,还是基于 OpenAI 开发;

4. LLM 相关的非共识判断。

以下为本次会议的详细实录。

Q1:GPT-4 之后,如何看模型能力演变和边界

GPT4 升级、能力提升影响很大,因为通

在此之前,大语言模型回答出错,经常是二话不说,直接先道歉,然后emmmmmm,继续乱猜。

现在,它不会这样了,有了新方法的加成,GPT-4不仅会反思自己哪里错了,还会给出改进策略。

比如说它会自动分析为什么“陷入循环”:

或者说反思一下自己有缺陷的搜索策略:

这是美国东北大学联合MIT发表的最新论文中的方法:Reflexion。

不仅适用于GPT-4,也适用于其他大语言模型,让它们学会人类特有的反思能力。

目前该论文已经发表在预印平台arxiv上。

这把直接让网友直呼“AI进化的速度已经超过我们适应的能力了,我们要被毁灭了。”

甚至有网友为开发人员发来“饭碗警告”:

用这种方法写代码的时薪是要比普通开发人员便宜的。

利用二元奖励机制实现反思

正如网友所言,Reflexion赋予GPT-4的反思能力和人类的思考过程差不多:

可以简单用两个字来概括:反馈。

在这个反馈过程中,又可以分为三大步:

1、评估:测试当前生成答案的准确性2、自我反省的产生:错误识别——实现修正3

在这个历史性的时刻,回答个问题,留下自己作为历史见证人的足迹。先遵循这个问题的主旨,写两句GPT-4开创了哪些新的方向,技术报告里很明确地指出了三个新的方向:

方向1:LLM最前沿研究的封闭化

第一,LLM最前沿研究的封闭化或小圈子化。技术报告里说了,出于竞争以及安全等方面的考虑,未公布模型规模等技术细节。从GPT 2.0的开源,到GPT 3.0的只有论文,再到ChatGPT连论文也没有,直到GPT 4.0的技术报告更像效果评测报告。一个很明显的趋势是,OpenAI做实了CloseAI的名号,之后OpenAI的LLM最前沿研究不会再放出论文。

在这个情形下,其它技术相对领先的公司有两种选择。

一种是做更极致的LLM开源化,比如Meta貌似选择了这条道路,这一般是竞争处于劣势的公司作出的合理选择,但是往往相关技术不会是最前沿的技术;

另外一种选择是跟进OpenAI,也选择技术封闭化。Google之前算是LLM的第二梯队,但在“微软+OpenAI”的一顿组合拳下,现在局面有点狼狈不堪。GPT 4.0去年8月就做好了,估计现在GPT 5.0正在炼丹过程中,这么长的时间窗口,结果

人工智能技术正在以惊人的速度发展,其中最引人注目的是OpenAI的大型语言模型(LLM)系列,即GPT。GPT是生成预训练变换器(Generative Pre-trained Transformer)的缩写,它可以根据输入的文本生成自然语言内容。从2018年的GPT-1到2022年初的GPT-3.5,GPT系列不断刷新着人工智能的记录,为我们带来了许多令人惊叹的应用,例如ChatGPT、Bing Chat等。

现在,OpenAI正准备推出下一代大型语言模型,即GPT-5。据传闻,GPT-5将在2023年12月完成训练,并有望达到人工通用智能(AGI)的水平,人工通用智能又被称为强人工智能,是指具有一般人类智慧,可以执行人类能够执行的任何智力任务的机器智能。如果这些传闻属实,那么GPT-5将成为人工智能技术的新里程碑,为我们的社会带来前所未有的变化和影响。

那么,GPT-5究竟有什么特点和能力呢?它又会对我们的生活产生什么样的冲击呢?本文将从以下几个方面对此进行简要介绍。

GPT-5的特点和能力

GPT-5是基于GPT-4进行改进和扩展的大型语言模型,它将继承并增强GPT-4的多模态处理

LLM(Language Model)和NLP(Natural Language Processing)是密切相关的概念,因为LLM是一种用于NLP的基本技术,它可以用于许多不同的NLP任务,例如语言生成、语言理解和机器翻译等。

GPT(Generative Pre-trained Transformer)是一种基于transformer架构的语言模型,它利用了大规模的语料库进行预训练,并可以用于许多不同的NLP任务,例如文本生成、文本分类和文本摘要等。因此,GPT模型是一种使用LLM技术的NLP模型。

Transformer是一种用于序列到序列(seq2seq)学习的神经网络架构,它在NLP领域中被广泛应用于许多任务,例如机器翻译、文本摘要和语音识别等。LLM技术可以用于 transformer模型的训练和优化,从而提高模型的性能和准确性。因此,LLM和transformer是相互关联的概念,它们在NLP领域中都起着重要的作用。