AIGC在互联网内容平台的应用场景和风控策略

互联网内容生态

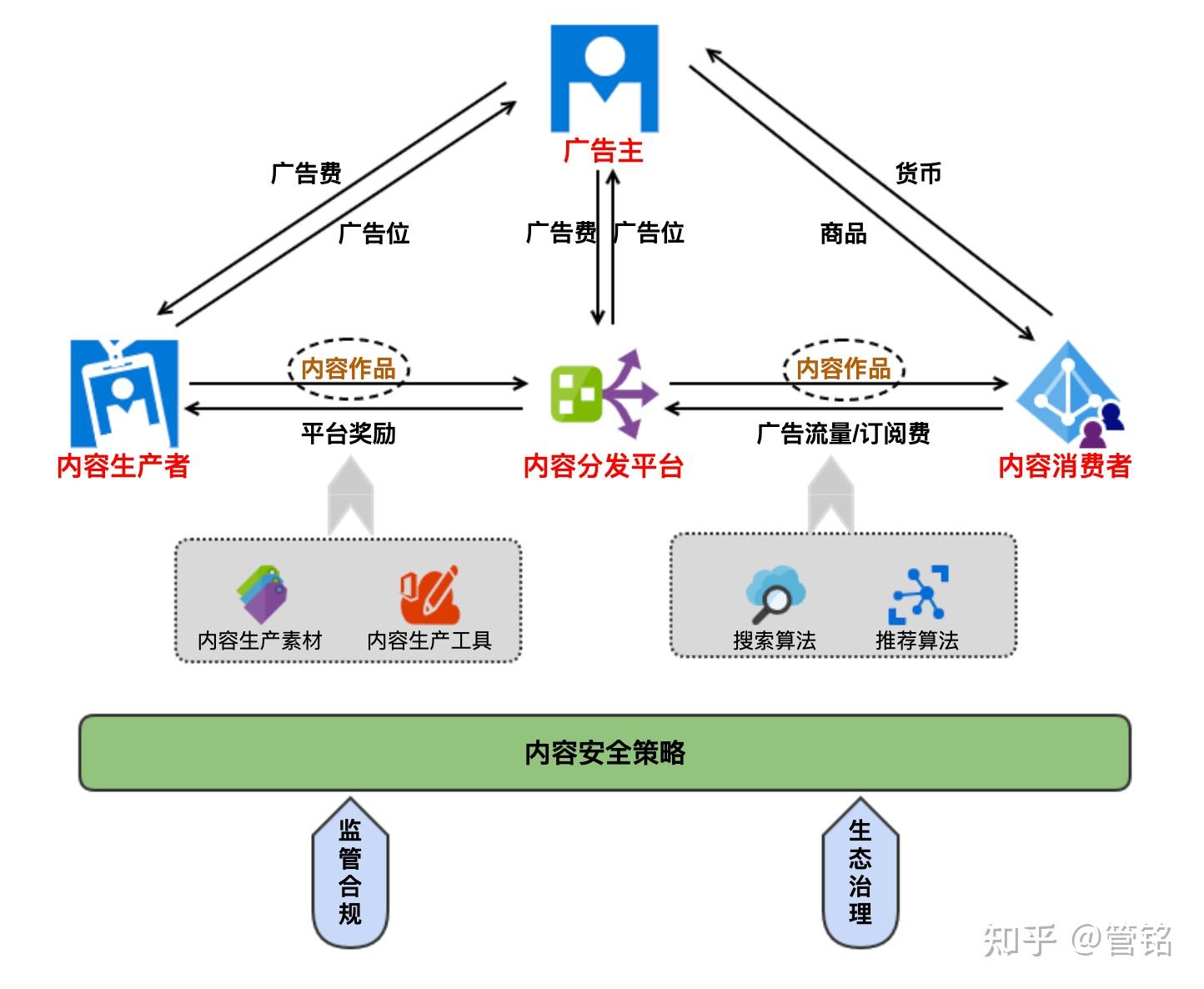

互联网内容生态,指的是内容作品在互联网中的生产、传播和消费,以及在此过程中产生的社会影响力。它有一个中心、四个关键主体、三个核心环节:

- 核心要素 :内容作品

- 关键主体 :内容生产者、内容消费者、内容分发平台、广告主

- 核心环节 :内容生产环节、内容消费环节、内容分发环节

好的互联网内容生态,一定是有大量优质的内容作品,满足了大量消费者的内容消费需求,甚至给整个生态圈、整个社会带来积极正面的影响。

内容素材网站、内容生产工具的出现,是为了降低内容创作者创作的门槛,提升内容作品生产效率。

而以搜索和推荐算法为核心竞争力的内容分发平台,则是为了解决如何将优质作品快而准地送达需要它的消费者手中。

内容素材和创作工具的迭代极大降低内容创作的难度,越发精准的算法极大降低内容传播的难度,这无意中也会增大低质甚至是突破人类道德底线的有害内容的产生和大肆传播,给生态圈和整个社会带来不好的舆论导向。

因此,在内容生产-分发-消费的全链路,我们都需要对内容质量进行管控,这样才能确保整个内容生态是在良性发展。

内容生产的四种范式

在web 1.0的时代,信息是单向传递的,媒体人经过前期的采编和后期制作完成内容生产,通过报纸、电台广播、门户网站,向广大观众传播内容,内容生产者往往是某个领域的专业权威人士,他们向内容分发平台售卖自己的内容作品,以此获得报酬,这种模式生产出来的内容作品我们叫 品牌生产内容(OGC,Occupationally-generated Content) 。

在web 2.0时代,普通用户也能在互联网平台发帖、直播、评论互动,他们往往不是某个领域的专业人士,生产的内容质量也良莠不齐,他们生产内容的动机往往是出于兴趣爱好或者某种情绪或者表达欲的宣泄,在自媒体时代也有博取关注流量的动机。这种模式生产出来的内容作品我们叫 用户生产内容(UGC,User-generated Content) 。

创作门槛的降低,导致可以进行内容创作的人数激增,内容创作的生产力被充分释放,于是UGC的内容占据了互联网内容生态的主流。但人类渴望高质内容产品的本质没有改变,在海量的良莠不齐的UGC中,还是有一部分出自创作者兴趣、有一定专业度的优质作品,我们把它叫做 专业生产内容(PGC,Professionally-generated Content) 。

PGC和OGC的最大区别在于创作的动机,OGC的创作动机是获得报酬,PGC的创作动机更多是兴趣爱好,是人类获得专业知识以后的分享欲、被认可和被需要的高级需求。

PGC和UGC的最大区别在于 内容专业度 的区别,PGC的创作主体更加专业,而UGC的内容更简单化、大众化。

web 3.0的本质是UGC内容所有权的归属,在我看来UGC所有权归属用户只是增加了内容传播的成本,并没有降低内容生产的难度,这并不利于生态圈的良性发展,从这个角度看是不work的。

而AI作为一种新的生产力要素被引入到内容生产中来,如果它的创作能力足够高强(模型的准确率足够高),就可以极大降低优质专业内容的创作门槛。

我曾采访国内某大型垂类社区内容负责人,他们调研chatGPT在他们领域的专业问题的回答准确率上已经达到70%,而80%是他们引入业务的最低要求。这意味着,可能稍微优化一次模型,他们这个社区上以约稿、问答收费为生的专家就得面临失业的窘迫了。但对于社区平台来说,却打开了一条更快、更低成本获取专业内容的路径。

除了从事这个行业的专家、专业内容创作者会受到冲击,产业链中的内容素材网站、内容创作工具也会受到极大的影响,AIGC不同于以往的深度学习算法,它不需要过多的中间态就能直接生成一段文字回答、一张图片、一段旋律、一篇小说,这一切都如丝般顺滑,省去了积累素材、工具剪辑的繁琐过程。

这种由AI模型生成的内容作品,我们把它叫做 人工智能生产内容(AIGC,AI-generated Content) 。

有意思的是,它并不是完全替代内容生产者,而是进一步降低生产优质内容的门槛,让普通人通过输入简短的信息也能快速生产专业内容,这仿佛否定了专业人士过往为了积累专业知识所付出的努力,所以我们现在看到有些机构禁止AIGC的内容,一方面也是为了保护专业人士,保护“一份耕耘、一份收获”的价值观,这个价值观类似版权保护。

从这个角度看,chatGPT是人类历史上最大的知识剽窃和侵权行为。这种“侵权”也不是谁都能做的,chatGPT一次的训练成本是在百万美金起步,前后烧掉数十亿美金才有了今天的效果。

当然禁止AIGC的内容也是在保护消费者,毕竟现在的模型准确率还不够高,存在较大的不确定性。如果以来模型输出的错误知识进行重大决策,导致了糟糕的结果,你都找不到责任人,你总不能和一个模型打官司吧。

| OGC | PGC | UGC | AIGC | |

|---|---|---|---|---|

| 场景 |

1、媒体人士的新闻报道

2、专业人士的作品创作 |

专业用户的作品创作 | 普通用户的内容生产 |

机器生成内容

1、智能对话 2、AI绘画 3、AI创作 4、...... |

| 内容质量 | 高 | 较高 | 低 | 未知 |

| 平台是否付费 | 是 | 否 | 否 | 训练成本/推理成本 |

| 消费者获取方式 | 付费订阅和购买 | 免费 | 免费 | 免费/付费订阅 |

AIGC在互联网内容平台的落地场景

智能对话

AIGC已经在互联网的多个场景有所落地,前商汤科技副总裁创立MiniMax,形成了文本到视觉(text to visual)、文本到语音(text to audio)、文本到文本(text to text)三大模态的基础模型架构,并于2022年11月上线了第一款产品Glow,目前用户已达百万。

这是一款定位机器人聊天的APP,笔者亲自体验,模型的知识储备和情绪表达确实达到了类人的程度。我们甚至还可以根据自己的喜好定义智能体,给智能体赋予“人设”。

AI绘画

针对图片生成的AI技术早在几十年前就已经商业化了, 1987/1988年, Photoshop软件诞生 ,代表着图像处理的数字化里程碑,其1991年引入的“滤镜(Filter)”功能,可以看做是最早的“智能图像处理”应用之一,2011年,美图秀秀开始推出手机版App,逐步从“手动修图”变成“自动智能修图”,而后进化到2015年FaceU激萌相机-视频自拍特效,再进化到最近几年抖音、快手的各种短视频和直播特效应用。

2022年底在抖音上大火的AI绘画,是让用户输入一张原图,可以生成各种类型的漫画图片,在添加上「群青」这首音乐,极大增加了平台内容创作的可玩性。

AI创作

除了联系上下文的语义对话和对图片的简单处理之外,AI还可以完成系统性要求更高的小说、音乐等文艺作品创作。主打出海娱乐社交的昆仑万维于今年1月发布了他们的AIGC全系列算法与模型-昆仑天工,其中的天工乐府SkyMusic支持从旋律生成歌词、文案素材生成歌词,且支持全球多曲风,该模型引入全局信息约束、和弦隐式表征,和弦准确率达到92.5%。

未来我们可以在更多的场景引入AIGC,例如垂类社区的专业知识问答,社区相册的特殊处理,小说诗词的内容创作,等等.....

AIGC给平台内容安全带来新的挑战

不管是在AI对话、AI绘画还是在AI创作场景,我们很难预测AI生成的内容是什么样的,就像我们很难预测一个经过训练的专业人士,如何回答我们的问题,创作出来的作品长什么样,这是AI算法的弱解释性决定的。

2016年微软发布的Tay,它可以通过推特学习社会信息并与他人互动。但是在仅仅一天后,Tay就开始说出一些种族歧视之类的偏激言论,因此微软暂时关闭了Tay的账号。但这些言论明显是和网络上一些有偏激言论的人互动后,被刻意教导出来的,因为微软当时还没有让Tay了解哪些言论是不适当的。

我国政府相关部门已经意识到这方面的内容风险,2022年12月11日,国家互联网信息办公室联合工信部、公安部公布了 《互联网信息服务深度合成管理规定》

规定指出:

任何组织和个人不得利用深度合成服务制作、复制、发布、传播法律、行政法规禁止的信息,不得利用深度合成服务从事 危害国家安全和利益、损害国家形象、侵害社会公共利益、扰乱经济和社会秩序、侵犯他人合法权益等法律、行政法规禁止 的活动。

并要求:

深度合成服务提供者应当加强深度合成内容管理,采取 技术或者人工方式 对深度合成服务使用者的 输入数据和合成结果进行审核 。

深度合成服务提供者发现 违法和不良信息的 ,应当依法采取处置措施,保存有关记录,及时向网信部门和有关主管部门报告;对相关深度合成服务使用者依法依约采取警示、限制功能、暂停服务、关闭账号等处置措施。

深度合成服务提供者应当建立健全辟谣机制,发现利用深度合成服务制作、复制、发布、传播 虚假信息 的,应当及时采取辟谣措施,保存有关记录,并向网信部门和有关主管部门报告。

深度合成服务提供者提供深度合成服务,可能导致公众混淆或者误认的,应当在生成或者编辑的信息内容的合理位置、区域进行 显著标识 ,向公众提示深度合成情况。

互联网应用商店等应用程序分发平台应当落实上架审核、日常管理、应急处置等安全管理责任,核验深度合成类应用程序的安全评估、备案等情况;对违反国家有关规定的,应当及时采取不予上架、警示、暂停服务或者下架等处置措施。

上文提到,AIGC的逐步普及会不断降低专业内容的创作门槛,这将会进一步提升内容增加的速度,但也增加了平台内容审核的难度,因为大量平台内容的准确性评估需要非常专业的知识储备,显然今天的内容审核人员还没有做好这方面的准备。

针对AIGC的风控策略

解决复杂问题的第一步是拆解问题,我认为当前AIGC的内容安全问题可以拆解为底线安全问题、虚假信息问题、专业知识准确度问题。

底线安全问题

即规定中指出的违法和不良信息,这类信息的规律和界定和UGC并无二致,当前的审核策略即可满足。但需要注意的是,我们不仅要对AIGC的合成结果内容进行审核,还要对使用AIGC的输入数据进行审核。

例如,在AI对话和AI绘画中,我们首先要对使用者输入的数据(文字、图片)进行审核,如果识别出有违规的数据,应该提示使用者并驳回这次生成请求,对于提示后还频繁输入违规数据的使用者账号要进行进一步的处罚。

对于收到正常数据请求后,经过AI算法推理生成的内容数据,审核违规的应该驳回,让模型重新生成,如果多次生成都有问题,要进行降级处理(反馈使用者服务失败等方式),并交由人工介入排查原因。

虚假信息问题

对普通审核员和深度学习算法来说,鉴别谣言还是有较高的难度的,但目前的风控系统对此也并不是束手无策。

- 针对 医疗健康、食品安全、社会科学 等谣言高发领域,我们可以通过人工或者机器的方式打上标签,通过账号聚集、时间和地点聚集策略来研判谣言的可能性,在未能判定之前尽量控制曝光量。

- 快速捕捉短时间内大面积传播的内容,并进行人工审核、实时追踪,有杀伤力的谣言往往具备这一特征。

- 建立投诉举报机制,专人审核用户投诉的谣言内容,并对发布谣言的使用者进行处罚。

专业知识准确度问题

谷歌的聊天机器人Bard在2月8日的发布会上的表现,已经让我们所有人都意识到AIGC生成的内容并不总是正确的,这种事实性的错误可能会给使用者带来决策上的灾难。AIGC的内容并不总是准确的,而使用AIGC的人并不总是专业的,如何有效甄别AIGC生成内容中的“错误答案”,帮助使用者规避错误答案导致的糟糕决策,是AIGC开发者不得不去解决的一个问题。

但这个问题看上去不像是一个内容风控问题,倒更像是AIGC本身的模型精度问题,但我们仍然可以引入一些平台用户的反馈机制,快速定位错误答案,在AIGC大模型没来得及重新迭代训练的时候,将错误答案的共性特征抽象出来,引入到风控策略中去,这样可以即时弥补系统的漏洞,尽量减少错误答案带来的Bad influence。