相关文章推荐

|

|

乖乖的牛肉面 · Docker容器IP访问容器服务_docke ...· 3 周前 · |

|

|

腼腆的红茶 · 容器组的静态 IP 地址 - Azure ...· 3 周前 · |

|

|

奔放的鼠标 · Azure 中的无服务器容器 - ...· 3 周前 · |

|

|

老实的弓箭 · 五、docker容器的网络访问 - yaowx · 3 周前 · |

|

|

乐观的甘蔗 · Alpine Docker ...· 昨天 · |

|

|

迷茫的鸵鸟 · 安全风险分级管控和隐患排查治理双重预防机制有关知识· 7 月前 · |

|

|

无邪的木瓜 · 团战大师-水龙敬!_哔哩哔哩_bilibili· 1 年前 · |

|

|

卖萌的紫菜 · 中国提前布局“星链”,10分钟扫描全球,让美 ...· 1 年前 · |

|

|

伤情的充电器 · 宁波富商82亿元买下杭州绕城高速--浙江在线 ...· 1 年前 · |

|

|

唠叨的豌豆 · 从比亚迪e-SEED ...· 1 年前 · |

推荐文章

|

|

老实的弓箭 · 五、docker容器的网络访问 - yaowx 3 周前 |

|

|

迷茫的鸵鸟 · 安全风险分级管控和隐患排查治理双重预防机制有关知识 7 月前 |

|

|

无邪的木瓜 · 团战大师-水龙敬!_哔哩哔哩_bilibili 1 年前 |

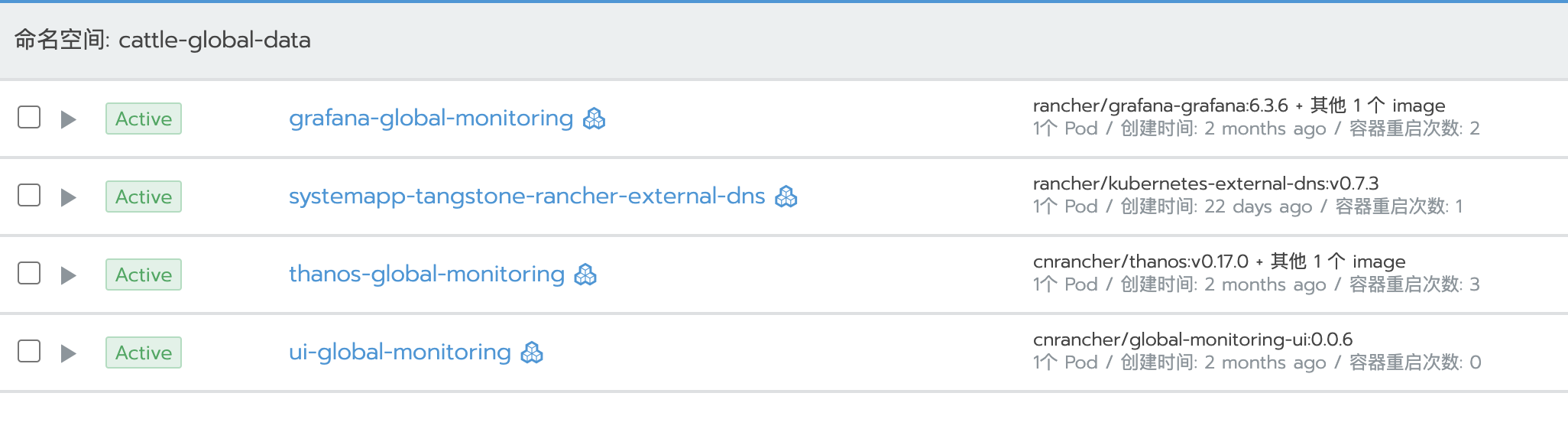

当遇到容器异常重启,应该进一步的找到容器重启的原因,避免下次再出现相同的问题。下面我将分享定位容器异常重启的几个步骤。

当遇到容器异常重启,应该进一步的找到容器重启的原因,避免下次再出现相同的问题。下面我将分享定位容器异常重启的几个步骤。