metadata:

name: cpu-demo-1

spec:

containers:

- name: cpu-demo

image: nginx

apiVersion: v1

kind: Pod

metadata:

name: cpu-demo-2

spec:

containers:

- name: cpu-demo

image: nginx

apiVersion: v1

kind: Pod

metadata:

name: cpu-demo-3

spec:

containers:

- name: cpu-demo

image: nginx

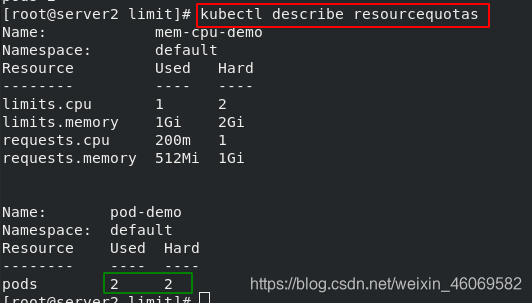

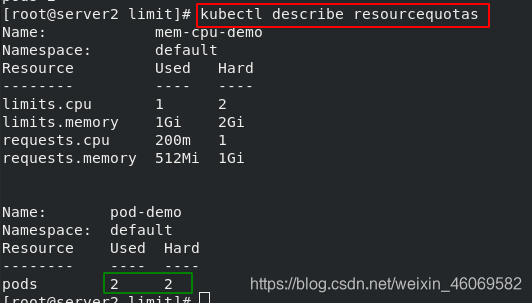

4)查看 ResourceQuota 的详情,pod限制数量被使用完

文章目录一、k8s容器资源限制1.1 内存限制1.2 cpu限制二、资源限制 LimitRange2.1 namespace的资源限制2.2 创建 pod 测试限制三、资源配额 ResourceQuota3.1 namespace 的资源配额3.2 pod 的配额【k8s容器资源限制:https://kubernetes.io/zh/docs/concepts/configuration/manage-resources-containers/#requests-and-limits】一、k8s容器

k8s容器资源限制一、基础知识(1)、资源限制(2)、资源类型二、内存限制三、cpu限制四、namespace设置资源限制(1)、设置namespace资源限制(2)、为namespace设置资源配额(3)、为namespace配置Pod配额

一、基础知识

(1)、资源限制

在K8s中定义Pod中运行容器有两个维度的限制:

资源需求:即运行Pod的节点必须满足运行Pod的最基本需求才能运行Pod。如: Pod运行至少需要2G内存,1核CPU

资源限额:即运行Pod期间,可能内存使用量会增加,那最多能使用多少

超出容器的内存限制

只要节点有足够的内存资源,那容器就可以使用超过其申请的内存,但是不允许容器使用超过其限制的 资源。如果容器分配了超过限制的内存,这个容器将会被优先结束。如果容器持续使用超过限制的内存, 这个容器就会被终结。如果一个结束的容器允许重启,kubelet就会重启他,但是会出现其他类型的运行错误。

本实验,我们创建一个Pod尝试分配超过其限制的内存,下面的这个Pod的配置文档,它申请5...

Kubernetes 作为当下最流行的的容器集群管理平台,需要统筹集群整体的资源使用情况,将合适的资源分配给pod容器使用,既要保证充分利用资源,提高资源利用率,又要保证重要容器在运行周期内能够分配到足够的资源稳定运行。

配置容器资源限制

对于一个pod来说,资源最基础的2个的指标就是:CPU和内存。Kubernetes提供了个采用requests和li...

kubernetes提供了两种资源限制的方式:ResourceQuota 和LimitRange。

其中ResourceQuota 是针对namespace做的资源限制,而LimitRange是针对namespace中的每个组件做的资源限制,如pod等。

对namespace中容器、pod等使用总和限制

ResourceQuota

对namespace中容器、pod等使用单独限制:

LimitRange

二。ResourceQuota

这里我们先说ResourceQu

Kubernetes采用request和limit两种限制类型来对资源进行分配。

request(资源需求):即运行Pod的节点必须满足运行Pod的最基本需求才能运行Pod。

limit(资源限额):即运行Pod期间,可能内存使用量会增加,那最多能使用多少内存,这就是资源限额。

资源类型:

CPU 的单位是核心数,内存的单位是字节。

一个容器申请0.5个CPU,就相当于申请1个CPU的一半,你也可以加个后缀m 表示千分之一的概念。比如说100